Ein Weg aus dem inneren Gefängnis

Die Lähmung beginnt schleichend, doch mit der Zeit erfasst sie den ganzen Körper. Irgendwann können Menschen, die an amyotropher Lateralsklerose erkranken, keinen Muskel mehr bewegen und auch nicht mehr mit ihrer Außenwelt kommunizieren. Forscher um Moritz Grosse-Wentrup suchen am Tübinger Max-Planck-Institut für Intelligente Systeme nach Wegen, die Betroffenen aus ihrer Isolation zu befreien, indem sie dem Computer beibringen, Gedanken zu lesen.

Text: Tim Schröder

Dass etwas nicht stimmt, merkt Wilfried Leusing, nachdem ihm Ärzte Implantate für eine Zahnprothese in den Kiefer gesetzt haben. Die Zunge fühlt sich taub an. Er kann nur undeutlich sprechen. Die Zunge müsse sich erst von der Operation erholen, sagen die Ärzte. Doch es wird nicht besser. Eine Neurologin schickt ihn in die Uniklinik Tübingen. Die Diagnose ist ernüchternd: „Verdacht auf Motoneuronerkrankung.“ Motoneurone sind Nervenzellen, die die Muskeln steuern – in den Fingern, im Brustkorb, in der Zunge.

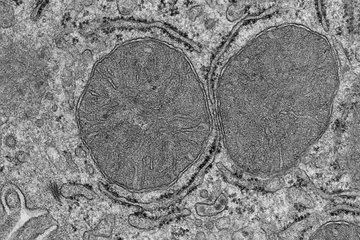

Die Schaltzentrale dieser Neurone befindet sich oben in der Mitte des Gehirns, in der Hirnrinde: ein dichtes Geflecht aus Nervenzellen, der Motorcortex. Versagen die Nervenzellen im Motorcortex, kann der Körper die Muskeln nicht mehr bewegen, obwohl diese intakt sind. Wilfried Leusing trägt es mit Fassung: „Es war kein Schlag für mich, aber für meine Frau“, sagt er heute. Damals, im Frühjahr 2010, sucht er weitere Spezialisten in Kliniken in München und Ulm auf: doch überall derselbe Befund.

Wilfried Leusing hat ALS, amyotrophe Lateralsklerose, eine Krankheit, bei der die Zellen im Motorcortex langsam absterben. Das Tempo, mit dem die Neurone ausfallen, variiert von Patient zu Patient. Manche Menschen können zwei Jahre nach der Diagnose Arme und Beine nicht mehr bewegen. Bei Wilfried Leusing schreitet die Krankheit langsamer voran.

Viele Erkrankte wollten an der Studie teilnehmen

Heute, vier Jahre nach dem Befund, kann er kaum noch sprechen. Auch das Schlucken fällt ihm schwer. Seit seine Zunge halbseitig gelähmt ist, sei ihm klar geworden, was für komplexe Vorgänge Kauen und Schlucken sind, schreibt er auf seiner Website „Das Alternativ“. „Die Zunge schiebt den Nahrungsbrei zwischen die Zähne und befördert ihn schließlich nach hinten.“ Mit der Lähmung geht das nicht mehr. Wilfried Leusing presst sich jetzt Flüssignahrung über einen kleinen Schlauch in den Magen. Was er erzählen möchte, tippt er in einen Tablet-PC ein. Ein Programm liest den Text dann vor.

Der direkte Draht zum Denken

„Durch die Krankheit habe ich das Schreiben neu für mich entdeckt“, erzählt er über seinen Computer. Er könne zwar nicht mehr durch Sprechen kommunizieren. Aber es gebe ja auch andere Wege, Inhalte und Emotionen rüberzubringen. „Ich habe ganz neue Erfahrungen gemacht, nicht trotz, sondern gerade wegen meiner Erkrankung.“ Seit wenigen Monaten nimmt Wilfried Leusing an einer Studie des Max-Planck- Instituts für Intelligente Systeme in Tübingen teil; auch das ist eine neue Erfahrung. Der Projektleiter ist Moritz Grosse-Wentrup, als Elektrotechniker zuständig für die Forschungsgruppe „Gehirn-Computer-Schnittstellen“.

Im vergangenen Jahr hatte Moritz Grosse-Wentrup im Internet Probanden gesucht. Rund 15 000 ALS-Erkrankte gibt es in Deutschland – viele haben sich gemeldet. Zunächst hat er vier Menschen für die Studie ausgewählt; einer von ihnen ist Wilfried Leusing, der ebenfalls in Tübingen lebt und Moritz Grosse-Wentrup mit seiner lebensbejahenden Haltung beeindruckt hat.

Mancher Patient ist im Körper eingeschlossen

Das Fatale an der Krankheit ALS ist, dass nach und nach alle Funktionen, für die der Körper Muskeln einsetzt, ausfallen. Es beginnt mit kleinen Lähmungen, dann versagen die Gliedmaßen. Zunge und Kehlkopf streiken, was das Schlucken unmöglich macht. Irgend wann liegt der Erkrankte da, unfähig, sich zu regen und zu kommunizieren, denn auch sprechen kann er nicht mehr. In manchen Fällen setzt die Augenmuskulatur aus. Dann können die Patienten ihr Gegenüber nicht mehr fixieren. „Fachleute nennen diesen Zustand locked-in“, sagt Grosse-Wentrup. „Der Patient ist in seinem Körper völlig eingeschlossen.“ Im Spätstadium können die Betroffenen nicht einmal mehr mitteilen, ob ihnen etwas wehtut. „Wir wissen von Patienten, deren Lungenentzündung zu spät bemerkt worden ist, weil sie sich nicht mehr mitteilen konnten.“

Einige Wissenschaftler, wie der Neurobiologe Niels Birbaumer von der Universität Tübingen, gehen davon aus, dass die Patienten nach und nach in einen traumartigen Zustand hinübergleiten. Ihre Theorie: Für gewöhnlich kann ein Mensch die Umwelt beeinflussen, durch Anfassen, Gesten, Sprache oder Blicke kommunizieren. Verliert der Mensch die Fähigkeit zur Interaktion, kehrt sich sein Bewusstsein nach innen. Es gibt keinen Kontakt mehr zur Außenwelt.

Die Verbindung nach draußen möchte Moritz Grosse-Wentrup wenigstens zu einem kleinen Teil wiederherstellen. Sein Ansatz klingt kühn: Im Spätstadium, wenn nichts mehr geht, soll der Patient über seine Gedanken, oder besser: die Hirnaktivität, kommunizieren. „Der Patient soll auf diese Weise Antworten auf einfache Ja/Nein-Fragen geben“, sagt Grosse-Wentrup. Haben Sie Schmerzen? Möchten Sie Radio hören?

Um ALS-Patienten diesen Weg aus dem inneren Gefängnis zu öffnen, müssen Grosse-Wentrup und seine Mitarbeiter zunächst aber lernen, die Denkaktivität richtig zu deuten. Sie sind nicht die Einzigen, die Gelähmten einen direkten Weg aus dem Gehirn zur Außenwelt verschaffen möchten – ohne Vermittlung irgendeiner Muskulatur. Unter anderen versuchen Forscher der Brown University in Providence in den USA mit Experten vom Deutschen Zentrum für Luft- und Raumfahrt, Signale aus dem Gehirn auszulesen und zu nutzen. Sie haben eine Methode entwickelt, mit der beispielsweise Querschnittsgelähmte eine Roboterhand bewegen können. Ihre Videos im Internet zeigen eine Probandin, die mit der Kraft ihrer Gedanken die Roboterhand zu einer Plastikflasche führt. Die Frau lächelt glücklich, als sie zum ersten Mal ohne Hilfe am Strohhalm saugt.

Die US-Forscher verwenden für ihre Experimente kleine Elektroden, die sie den Patienten unter den Schädelknochen direkt in den Motorcortex implantieren. Diese Elektroden nehmen die Aktivität der Neurone wahr. Der Trick besteht darin, dass sogar gedachte Bewegungen die Neurone im Motorcortex anregen. Der Motorcortex ist bei vielen Gelähmten also auch dann aktiv, wenn der Körper die Bewegung gar nicht ausführt. Die Elektroden nehmen die Signale der Neuronen auf und leiten sie zu einem Computer, der die Impulse in Steuerbefehle für den Roboterarm übersetzt. Natürlich muss der Patient lange trainieren. Am Ende aber reicht es, dass er sich eine Handlung vorstellt, um den Roboter zu steuern. Die Erfolge der USForscher sind beeindruckend.

Bei ALS-Patienten aber klappt das nicht, weil bei ihnen ja ausgerechnet der Motorcortex gestört ist. „Wir müssen also andere Hirnregionen, andere Signale finden, über die der ALS-Patient kommunizieren kann“, sagt Grosse- Wentrup. Es sieht ganz so aus, als habe Grosse-Wentrup einen Weg gefunden. Seit einigen Jahren wissen Neurologen, dass bei verschiedenen Tätigkeiten verschiedene Hirnbereiche gleichzeitig aktiv sind. Das Denken findet nicht an einem einzigen Punkt im Gehirn statt. Stattdessen funken bestimmte Areale bei verschiedenen Denkprozessen in einer Art fein abgestimmter Polyphonie.

Besonders interessant ist für Moritz Grosse-Wentrup ein Aktivitätsmuster, das auftritt, wenn ein Mensch sich auf sich selbst konzentriert, die Gedanken nach innen richtet, meditiert: das Default- Mode-Network oder Ruhezustandsnetzwerk. Dabei sind gleichzeitig ein Bereich hinter der Stirn und ein zweiter tiefer im Gehirn aktiv. Konzentriert sich der Mensch hingegen auf eine Tätigkeit – liest oder rechnet er –, dann nimmt die Aktivität des Default-Mode- Networks ab.

Das Ruhestandsnetz ist weniger betroffen von ALS

Grosse-Wentrup glaubt, dass ALS-Patienten durch einen solchen Wechsel zwischen zwei Konzentrationszuständen auch im Spätstadium kommunizieren und Ja/Nein-Antworten geben können. Denn das Ruhezustandsnetzwerk ist von der ALS-Erkrankung weniger betroffen als der Motorcortex.

Das Experiment der Tübinger sieht folgendermaßen aus: Mithilfe ihrer Gedanken müssen die Patienten versuchen, eine Kugel auf einem Bildschirm nach oben oder unten zu bewegen. Oben heißt „Ja“, unten heißt „Nein“. Die Höhe der Kugel entspricht der Stärke der Aktivität im Default-Mode-Network – Änderungen im Erregungszustand bewegen den Ball daher. Seitlich kann sich der Ball derzeit nicht verschieben.

Anders als die Forscher in den USA benutzt Grosse-Wentrup keine Elektroden, die direkt in den Cortex implantiert werden. Die Infektionsgefahr sei zu groß, sagt er. Außerdem bildeten sich durch Abstoßungsreaktionen des Körpers auf den Elektroden häufig Beläge, sodass die Signalleitung zum Computer gestört wird. Er benutzt daher lieber das klassische Elektroenzephalogramm (EEG). Der Proband setzt dafür eine Haube mit vielen kleinen Elektroden auf, welche die elektrischen Signale der Neuronen durch den Schädelknochen hindurch wahrnehmen. Natürlich ist ein solches Signal ungenauer als jenes von Elektroden, die direkt auf dem Gehirn sitzen. Doch das reiche erst einmal, sagt Grosse-Wentrup.

„Ich gebe den Probanden möglichst wenig vor“, sagt er. „Jeder Patient muss für sich einen eigenen Weg finden, Gehirnaktivität im Default-Mode-Network zu beeinflussen und dadurch den Ball nach oben oder unten zu bewegen.“ Sich meditativ nach innen zu wenden ist nur eine Möglichkeit, das Ruhezustandsnetzwerk zu aktivieren. Einigen gelingt das auch, indem sie verschiedene Emotionen in sich wecken. Denn verschiedene Gefühle führen auch zu einer unterschiedlichen Aktivität im Default-Mode-Network.

Die Elektroden der EEG-Haube werden mit etwas Gel eingeschmiert, damit sie die elektrische Erregung im Gehirn besser aufnehmen. „Und so hatte ich nach meiner ersten Sitzung im Januar zum ersten Mal in meinem Leben Gel im Haar“, sagt Wilfried Leusing, der einen langen weißen Bart und lange Haare trägt.

Knapp zehnmal waren Grosse-Wentrup und seine Leute inzwischen bei ihm und den anderen Probanden. „Mit Auf- und Abbau dauert eine solche Sitzung etwa fünf Stunden, das ist ganz schön aufwendig“, lässt Leusing seinen Computer sagen. „Aber es ist ein Supergefühl, wenn man mit tollen Menschen zusammen etwas erarbeiten kann, das sinnvoll ist. Und mein Beitrag bin einfach ich.“ Inzwischen kann Leusing den Ball flott nach oben bewegen. „Wenn er sich in eine falsche Richtung bewegt, bekomme ich ihn mit einem gedachten ,Nein’ wieder in die andere Richtung.“ Bewusst nach unten drücken kann er ihn jedoch noch nicht. Übung macht eben den Meister.

Für Moritz Grosse-Wentrup und seine Mitarbeiter beginnt die eigentliche Arbeit, wenn sie wieder im Institut sind: die Analyse des EEG. Als Laie erkennt man im Elektroenzephalogramm zunächst nur einige Zitterlinien, die langsam von rechts nach links über den Bildschirm kriechen. Sie zeigen die Hirnaktivität als elektrische Spannung an. Die Linien unterscheiden sich in der Geschwindigkeit des Zitterns, der Geschwindigkeit der Spannungsänderung. Mediziner sprechen von Frequenzbändern oder Wellen.

Die Software lernt die Zittermuster zu deuten

Und von den Wellen gibt es viele: Die Hauben, die Grosse-Wentrup und seine Mitarbeiter ihren Probanden aufziehen, sind mit 128 Elektroden bestückt, die jeweils 40 Frequenzbänder aufnehmen. Pro Messung kommen so mehr als 5000 Variablen zusammen. Eine Datenfülle, die kein Mensch überblicken kann. Um die Signale zu interpretieren, nutzt Grosse-Wentrup deshalb statistische Rechenverfahren, die im Max-Planck- Institut für Intelligente Systeme entwickelt worden sind. Ziel ist es, in dem Gewimmel aus Zitterlinien charakteristische Muster zu erkennen, die immer dann auftreten, wenn der Patient den Ball bewegt.

Welches Zittermuster typisch ist, findet die Software durch eine Art Lernprozess heraus, in dem sie die vielen Messwerte ordnet. Wie das funktioniert, erläutert Bernhard Schölkopf, Direktor am Institut und zuständig für die Abteilung Maschinelles Lernen, an einem einfachen Beispiel. „Stellen Sie sich vor, ein Computer müsse zwischen einer undeutlich hingeschmierten Acht und einer Neun unterscheiden“, sagt Schölkopf. „Das ist zunächst unmöglich. Wenn man dem Computer aber unzählige Achten und Neunen präsentiert, ihn also auf die Zahlen trainiert, dann lernt er zu unterscheiden.“

Bei einem solchen Verfahren ordnet der Computer die Pixel, aus denen die Zahl besteht, in einem multidimensionalen Raum an und vergleicht sie mit den antrainierten Daten. Er vergleicht und analysiert, mit welcher Wahrscheinlichkeit die Pixel eher mit dem erlernten Muster der Acht oder jenem der Neun deckungsgleich sind. Nach ähnlichen statistischen Lern- und Entscheidungsverfahren arbeiten auch vollautomatische Postsortiermaschinen, die hingeschmierte Buchstaben auf Briefumschlägen erkennen können. Moritz Grosse-Wentrup versucht jetzt, den Computer auf die Frequenzbänder des EEG zu trainieren. Der Computer soll lernen, charakteristische Aktivitätsmuster im Hirn schneller und sicher zu erkennen, wenn der Patient den Ball bewegt.

Letztlich geht es darum, dass Proband und Computer sich schnell verstehen. Immerhin soll der Computer die gedachten Befehle des Probanden künftig zügig in eine Antwort umsetzen. Der Patient muss lernen, den Ball auf dem Bildschirm zu steuern, der Computer, wie die entsprechenden Aktivitätsmuster aussehen, damit er sie sicher und zügig in die Ballhöhe umsetzt. „Wir sehen bereits, dass wir auf Fragen desto schneller eine richtige Antwort erhalten, je besser der Computer die Frequenzmuster erlernt“, sagt Grosse- Wentrup. Für den Alltag der ALS-Patienten wird das später essenziell sein, denn auf eine einfache Frage wie „Haben Sie Schmerzen?“ soll es natürlich eine schnelle Antwort geben.

Zusammen mit Niels Birbaumer von der Universität Tübingen arbeitet Schölkopfs Abteilung seit zehn Jahren daran, mit ALS-Kranken über Denkbefehle zu kommunizieren. Allerdings hatten sie zunächst Denkprozesse und Vorstellungen gewählt, die letztlich ungeeignet waren. Es zeigte sich, dass die Denkprozesse und Spannungsmuster der Neuronen zu stark von der Tagesform des Patienten abhingen und der Computer das Denken nur schlecht interpretieren konnte. Als die Krankheit fortschritt, versagten die Methoden irgendwann ganz. „Moritz scheint ein anderes Paradigma, einen anderen Denkprozess gefunden zu haben, der robuster ist“, sagt Schölkopf.

Um den Computer mit vielen Trainingsdaten füttern zu können, testet Grosse-Wentrup sein Verfahren auch an gesunden Studienteilnehmern. In den vergangenen fünf Jahren haben er und seine Mitarbeiter bei etwa hundert Studenten EEG-Messungen vorgenommen. Es sieht ganz so aus, als sei Grosse-Wentrups Verfahren tatsächlich robust. Zwar muss sich die Computer-Lernmaschine bei jedem Versuch einige Zeit auf die Denkmuster des Probanden einstellen, doch recht bald bewegt sich der Ball. Ganz offensichtlich gibt es also Denkmuster, die bei allen Menschen ähnlich genug sind, sodass maschinelle Lernverfahren sie erkennen können. Dabei laufen Denkprozesse im Detail bei jedem Patienten etwas anders ab und verändern sich mit der Tagesform.

Da Moritz-Grosse Wentrup erst seit knapp einem halben Jahr mit Wilfried Leusing und den anderen ALS-Patienten arbeitet, ist noch offen, ob seine Methode auch im Spätstadium der Krankheit funktionieren wird. Dass sie schon jetzt sehr robust ist, lässt ihn hoffen. Bei einem seiner Patienten schreitet die Krankheit schnell voran, er hat bereits Schwierigkeiten, die Gliedmaßen zu bewegen. Bei ihm könnte sich als Erstem zeigen, ob die neue Methode ein verlässlicher Weg zur Außenwelt ist, wenn sich der Körper langsam schließt.

Mehr Messdaten nötig

Moritz Grosse-Wentrup hatte sich ursprünglich für das Elektrotechnik-Studium entschieden, um später in die Robotik einzusteigen. Dann erfuhr er von den Arbeiten an ALS-Patienten. Die Arbeit für Menschen sei für ihn heute sehr viel erfüllender als Robotik, sagt er. Sollte sich zeigen, dass seine Methode, sein Denkmuster-Paradigma, auch im Spätstadium der Krankheit funktioniert, dann kann er sich vorstellen, vom EEG auf implantierte Elektroden umzusteigen, die nicht über ein Kabel an einen Computer angeschlossen sind, sondern die Daten per Funk übertragen. Entsprechende Elektroden werden derzeit entwickelt. Eine solche Elektrode wäre für den Alltagseinsatz ideal. Und sie würde deutlichere Frequenzsignale liefern.

Doch zunächst benötigt Grosse- Wentrup mehr Messdaten von seinen ALS-Patienten. Wilfried Leusing will seinen Teil dazu beitragen und sich weiterhin einmal pro Woche mit den Forschern treffen. Grosse-Wentrup oder seine Mitarbeiter kommen dann jedes Mal mit einem Wäschekorb voller Kabel und Elektroden vorbei. „Es ist für jeden Menschen wichtig, dass ihm bewusst ist, welche Rolle er in seinem Leben spielt“, teilt Wilfried Leusing über seinen Computer mit. Eine seiner Rollen ist die des Probanden, der seinen Teil dazu beiträgt, ALS-Kranken künftig ein Stück weit das Leben zu erleichtern – selbst wenn er davon vielleicht nicht mehr selbst profitieren wird.

AUF DEN PUNKT GEBRACHT

Patienten, die an amyotropher Lateralsklerose (ALS) erkranken, leiden unter einer fortschreitenden Lähmung. Irgendwann können sie nicht mehr sprechen und manchmal nicht einmal mehr die Augen bewegen. Damit verlieren sie jede Möglichkeit, mit der Außenwelt zu kommunizieren.

Forscher um Moritz Grosse-Wentrup vom Max-Planck-Institut für Intelligente Systeme in Tübingen wollen ALS-Patienten einen Weg aus der inneren Isolation öffnen. Sie bringen den Betroffenen bei, über die Aktivität im Default-Mode-Network einen Ball auf einem Computerbildschirm zu steuern und so Ja/Nein-Antworten zu geben.

Die Aktivität im Default-Mode-Network greifen die Wissenschaftler mithilfe von Elektroden ab, die wie beim EEG am Kopf angebracht werden. Mit Methoden des maschinellen Lernens bringen sie einem Computer bei, das Erregungsmuster im Gehirn zu interpretieren und in Steuersignale umzusetzen.

Derzeit verfeinern die Forscher die Methoden, mit denen die Gehirnaktivität analysiert wird, mithilfe von vier ALS-Patienten und rund hundert gesunden Probanden.

GLOSSAR

Amyotrophe Lateralsklerose – ALS: Bei dieser neurodegenerativen Erkrankung sterben die Nervenzellen im Motorcortex langsam ab, sodass betroffene Patienten letztlich keine Bewegung mehr ausführen können.

Default-Mode-Network: Das Default-Mode-Network, auch Ruhezustandsnetzwerk genannt, besteht aus Arealen im vorderen und hinteren Bereich des Gehirns, die besonders im Ruhezustand, aber auch bei Emotionen aktiviert sind.

Maschinelles Lernen: Dabei lernen Computer, Muster in Daten zu erkennen, indem sie Beispiele analysieren und daraus allgemeine Regeln ableiten. Auf diese Weise können sie etwa Handschriften entziffern oder Aktivitätsmuster im Gehirn interpretieren.