Roboter mit sanfter Hand

Damit Maschinen Menschen künftig bei einer Therapie oder im Alltag unterstützen können, müssen sie ihr Gegenüber ertasten und behutsam anfassen können. Die dafür nötige Technik entwickeln Katherine J. Kuchenbecker und ihr Team am Max-Planck-Institut für Intelligente Systeme in Stuttgart. Die Forschenden testen auch bereits feinfühlige Roboter für erste Anwendungen.

Text: Andreas Knebl

Warm und geborgen. Und sicher. So sollte man sich in einer Umarmung fühlen. Und so fühlt es sich auch an, wenn sich die kräftigen Arme von HuggieBot schließen und man an seine warme, breite Brust gedrückt wird. Der Vorzeige-Roboter der Abteilung Haptische Intelligenz des Max-Planck-Instituts für Intelligente Systeme in Stuttgart umarmt sein menschliches Gegenüber routiniert. Doch bis HuggieBot ein guter Partner für Umarmungen wurde, war es ein weiter Weg für Katherine J. Kuchenbecker und ihr Team. Denn Maschinen das Fühlen beizubringen, also den Tastsinn in Technik zu übersetzen, ist anspruchsvoll und das Forschungsfeld noch jung. Ziel von Kuchenbecker ist es, haptische Interaktionen zu verstehen und dadurch das Zusammenspiel zwischen Menschen, Maschinen und physischen Objekten zu verbessern. Mit haptischen Interaktionen sind dabei Kontakte mit Robotern gemeint, bei denen es um die tastende Wahrnehmung geht. „Letztlich will ich interaktive Robotersysteme erschaffen, die Menschen wirklich helfen können.“, sagt Kuchenbecker. Ihr Augenmerk liegt dabei besonders auf haptischen Anwendungen für Roboter, die bedürftige Menschen bei einer Therapie oder im Alltag unterstützen.

Für die Forschenden ist HuggieBot bestens geeignet, solche tastenden Mensch-Roboter-Interaktionen zu studieren. Denn am Beispiel der Umarmung können die Forschenden erproben, welche Bedingungen ein Roboter erfüllen muss, damit Menschen mit ihm gerne körperlich interagieren. Während sich Pflegeroboter oftmals komplexere und intimere Berührungen ausführen müssten, sind die Umarmungen von HuggieBot relativ einfach und unverfänglich. Trotzdem verlangen sie viel Gefühl. Da Umarmungen für die meisten Menschen angenehm sind, ist es zudem leicht, Studienteilnehmer zu gewinnen, die den Roboter testen. Ziel von Alexis E. Block, der leitenden Wissenschaftlerin des Projekts, und Kuchenbecker ist es, dass HuggieBots Umarmungen genauso beruhigen, trösten und Geborgenheit geben wie die Umarmung eines Menschen. Haptisch intelligente Roboter könnten in Zukunft dann auch die Lücke schließen, die zwischen virtueller und physischer Welt klafft. Denn im virtuellen Raum findet ein zunehmender Teil sozialer Begegnungen statt. Roboter mit Tastsinn könnten es Menschen, die eigentlich weit voneinander entfernt sind, erlauben, Berührungen auszutauschen.

Um HuggieBot zu entwickeln, untersuchten Kuchenbecker und Block zunächst, welche physischen Eigenschaften ein Roboter mitbringen sollte, damit Menschen seine Umarmungen als natürlich und angenehm empfinden: Sie fanden heraus, dass er weich, warm und ungefähr so groß wie ein Mensch sein sollte. Außerdem sollte er Menschen, die mit ihm interagieren, visuell wahrnehmen und seine Umarmung an die Größe und Körperhaltung der Person anpassen. Schließlich muss der Roboter erkennen, wann er die Umarmung beenden soll. Inzwischen haben die Forschenden verschiedene Versionen von HuggieBot entwickelt. HuggieBot 2.0 etwa konstruierten sie völlig neu, nachdem sie zunächst mit einem leicht abgewandelten und umprogrammierten kommerziellen Roboter gearbeitet hatten. HuggieBot 2.0 besteht aus einem zentralen Gestell, einem Oberkörper, der wie ein Wasserball aufgeblasen wird, zwei Industrieroboterarmen und einem Bildschirm als Kopf und ist in ein graues Sweatshirt sowie einen langen lila Rock gekleidet. Erkennt er mithilfe der Kamera, die sich oberhalb des Bildschirms befindet, eine Person in seinem Umfeld, fragt er: „Can I have a hug, please?“, also etwa: „Kannst du mich bitte umarmen?“ Auf dem Bildschirm erscheint dabei ein freundliches Gesicht. Falls sich die Person daraufhin annähert, stellt sich HuggieBot auf eine Umarmung ein und taxiert die Größe der Person. Sobald die Person in Reichweite der Arme ist, schließt er die Arme und drückt die Person an seine Brust. Diese fühlt sich weich und warm an, weil sie luftgepolstert und beheizt ist. Sensoren und eine Steuerung der Arme sorgen dafür, dass der Druck, mit dem HuggieBot die Person in seine Arme schließt, einer herzlichen Umarmung entspricht. Erwidert die Person die Umarmung, nimmt HuggieBot dies durch einen Drucksensor wahr, der im hinteren Teil seines luftgefüllten Oberkörpers liegt. Wenn die Person den Druck löst oder sich leicht gegen die Arme von HuggieBot lehnt, um die Umarmung zu beenden, öffnet der Roboter seine Arme. So kommt es nicht zum unangenehmen Gefühl einer ungewollt langen Umarmung, und die Interaktion mit dem Roboter wird als sicher empfunden. Wie gut die haptischen Elemente und die Steuerung von HuggieBot arbeiten, zeigte sich in Studien mit Probanden. In einer Untersuchung tauschten die Teilnehmer jeweils acht Umarmungen mit dem Roboter aus, bei denen die Forschenden unterschiedliche Funktionen an- oder ausschalteten. Die Ergebnisse der anschließenden Befragungen zeigten klar, dass die haptische Wahrnehmung eine große Rolle spielt: Wenn der Roboter sich an ihre Größe anpasst und die Umarmung reaktiv beendet, empfanden die Probanden das als angenehmer und bewerteten die Interaktion positiver.

Neben HuggieBot arbeitet das Team um Kuchenbecker an zahlreichen weiteren Projekten, bei denen der Tastsinn gefragt. So forschen ihre Mitarbeiter beispielsweise an technischen Möglichkeiten, Berührungen wahrzunehmen und zu übertragen, an einem ferngesteuerten Montageroboter sowie an einer Roboterhand, die Gegenstände greift und anhand der erstasteten Eigenschaften klassifiziert. Außerdem entwickelt das Team weitere Roboter, die auf kommerziellen Plattformen basieren, zusätzlich aber haptische Fähigkeiten besitzen, um damit Menschen zu helfen: Hera, der die Behandlung von Kindern mit Autismus unterstützen soll und Max, der mit Menschen in Rehabilitation oder im Alter Sport treiben soll. Dass die Forschung in Kuchenbeckers Abteilung so breitgefächert ist, liegt auch an den Erfahrungen der Wissenschaftlerin mit Teamleistungen: Aus ihrer Zeit als Volleyballspielerin in der sehr leistungsorientierten Mannschaft der Stanford University hat Kuchenbecker verinnerlicht, dass Erfolg Teamsache ist und von verschiedenen Perspektiven und Fertigkeiten profitiert. Darin liegt sowohl ihr motivierender Führungsstil als auch ihre Bereitschaft begründet, den Forschenden in ihrer Abteilung die Möglichkeit zu geben, eigene Ideen zu verfolgen. Der Erfolg dieses Ansatzes lässt sich auch daran ermessen, dass viele Wissenschaftlerinnen und Wissenschaftler aus Kuchenbeckers Gruppe anschließend begehrte Stipendien oder akademische Stellen ergattern.

Auch bei der Wahl der Forschungsrichtung spielte Kuchenbeckers Biografie eine Rolle. Als Tochter eines Chirurgen und einer Psychologin entschied sie sich für ein Studium des Maschinenbaus, um Technik und menschliche Fürsorge zusammenzubringen. So befasste sich Kuchenbecker schon in ihrer Doktorarbeit an der Stanford University damit, wie man ferngesteuerte Operationsroboter verbessern könnte, indem man deren bisher rein visuelle Steuerung durch haptische Rückmeldungen ergänzt. Daraus ergab sich eine viel allgemeinere Fragestellung: Wie können Tastinformationen technisch übersetzt und wiedergegeben werden? Und wie können diese zusätzlichen sensorischen Informationen dabei helfen, das Zusammenspiel zwischen Mensch und Technik zu verbessern?

Bislang herrscht in dieser Hinsicht ein starkes Ungleichgewicht. Während audio-visuelle Informationen seit langer Zeit und mit immer größerer Finesse aufgezeichnet und wiedergegeben werden können, fehlt vergleichbare Technik für den Tastsinn. Für haptische Eindrücke gab es lange weder ein Äquivalent zu Kamera oder Mikrofon noch zu Bildschirm oder Lautsprecher. Daher erlauben es uns Computer und auch Smartphones mit Touchbildschirm bislang nicht, digitale Gegenstände physisch zu ertasten. Ebenso sind die meisten Maschinen und somit auch Roboter unbeholfen, wenn sie Gegenstände oder Menschen berühren sollen. Denn außer Kameras und einfachen Kraftsensoren steht den Robotern noch keine kommerzielle Technik zur Verfügung, um Informationen über ihre physischen Interaktionen zu sammeln. Daher fällt es ihnen schwer festzustellen, ob ein Objekt beispielsweise hart und glatt oder weich und rau ist. Genauso wenig kann ein herkömmlicher Roboter fühlen, ob und vor allem wie ihn ein Mensch berührt. Doch genau diese physische Interaktion zwischen Mensch und Roboter ist für viele Anwendungen entscheidend.

Das Projekt Hera führt daher mehrere Forschungsstränge der Abteilung Haptische Intelligenz zusammen. Hera steht für haptisches empathisches Robotertier (engl. haptic empathetic robot animal); Rachael Bevill Burns, die das Projekt als Doktorandin leitet, entwickelt es, um bei der Erziehung von Kindern mit Autismus zu helfen. Diese haben oft Probleme mit sozialen Berührungen. Solche Berührungen dienen üblicherweise dazu, Aufmerksamkeit einzufordern, ein Bedürfnis zu kommunizieren oder ein Gefühl zum Ausdruck zu bringen. Doch viele Kinder mit Autismus lehnen Berührungen entweder ab oder suchen – am anderen Ende des Spektrums – zwar zwischenmenschliche Berührungen, haben aber kein Gefühl dafür, welche Berührung angemessen ist. So kann es passieren, dass sie eine andere Person zu kräftig, zu häufig oder an den falschen Stellen anfassen. Aktuell erlernen Kinder mit Autismus den sicheren Umgang mit Berührungen meist von einem Ergotherapeuten. Burns und Kuchenbecker möchten die bisherigen Möglichkeiten für Therapie und Betreuung mit haptisch intelligentem Roboter wie Hera erweitern. Welchen Beitrag diese leisten können und welche Eigenschaften sie dazu mitbringen sollten, hat das Team durch die Befragung von zahlreichen erfahrenen Therapeuten und Betreuern untersucht.

Auf Basis der Umfrageergebnisse entwickeln sie nun Hera, der auf dem kleinen humanoiden Roboter Nao basiert. Für den Einsatz als Therapiehilfe haben die Max-Planck-Forscherinnen ihn in ein Koalakostüm gehüllt. Unter der plüschigen Hülle trägt Hera am ganzen Körper Berührungssensoren, um die körperliche Interaktion zwischen Kind und Roboter aufzuzeichnen. Wie von den Therapeuten bestätigt, erfordert diese Anwendung Sensoren, die weich sind und sowohl leichte als auch feste Berührungen detektieren. Und das auf all den gekrümmten Oberflächen des Roboters. Da solche Sensoren kommerziell nicht erhältlich sind, entwickelt Kuchenbeckers Team selbst textile Sensormodule mit den entsprechenden Merkmalen. Ein einzelnes Modul besteht dabei aus mehreren Schichten Stoff mit hoher und niedriger elektrischer Leitfähigkeit. Wird das Sensormodul berührt, so werden die Schichten zusammengedrückt, und der elektrische Widerstand zwischen den beiden äußeren Schichten sinkt. Abhängig davon, wie stark, wie oft und mit welcher Frequenz der Widerstand sinkt, klassifiziert ein Algorithmus die Berührungen etwa als Stupsen, Kitzeln, Schlagen oder Drücken. „Während bei kommerziellen Robotern oftmals nur in den Handgelenken Kraftsensoren verbaut sind, wird Hera durch unsere textilen Sensoren am ganzen Körper Berührungen spüren und darauf reagieren können“, sagt Kuchenbecker. So kann Hera feststellen, ob die sozialen Berührungen des Kindes angemessen sind, oder ob das Kind beispielsweise zu fest zupackt oder den Roboter an einer Stelle berührt, die die meisten Menschen als unpassend empfinden, etwa im Gesicht. Auf solche Übergriffe wird der Roboter so abwehrend oder missbilligend reagieren wie ein Mensch oder auch ein Tier, aber auch anerkennen, wenn das Kind lernt, sie angemessener zu berühren. Burns und Kuchenbecker stellen sich vor, dass ein Therapeut Kindern mit einem Roboter wie Hera ein sicheres Gespür vermitteln könnte, wie man andere berührt.

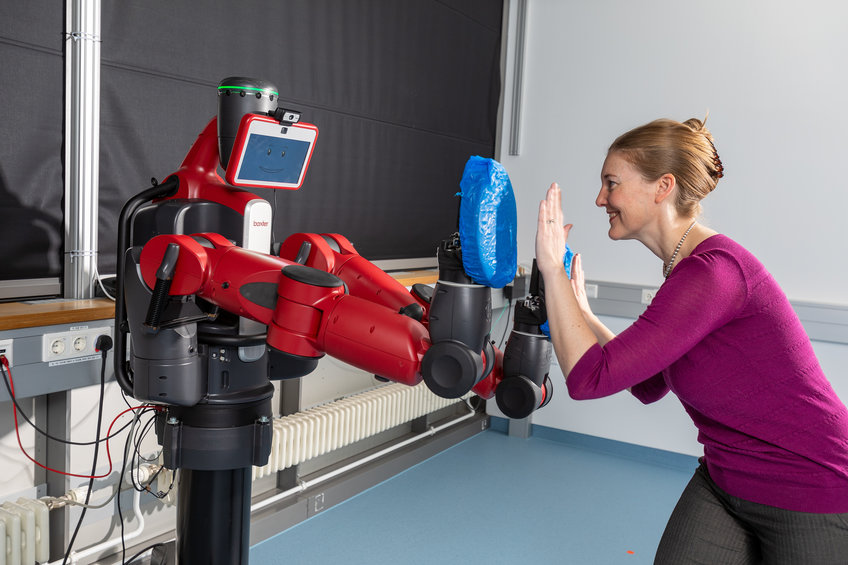

Als Trainingshilfe könnte auch ein weiteres interaktives Robotersystem dienen – diesmal für ältere Menschen oder Patienten in der Rehabilitation etwa nach einer Operation oder einem Schlaganfall. Max, der Motivational Assistive eXercise Coach, kann mit seinem menschlichen Partner leichte Bewegungsspiele machen, ohne müde zu werden. Er basiert auf Baxter, einem Roboter, der einem menschlichen Oberkörper nachempfunden ist und eigentlich für die industrielle Fertigung entwickelt wurde. Bei einem Spiel mit Max muss man die Hände des Roboters wiederholt abklatschen, um ihn aufzuwecken. Bei anderen Spielen sollen sich die Partner des Roboters ein langes Abklatsch-Muster merken, die Arme weit ausstrecken oder yogaähnliche Posen einnehmen, die Max vorführt. Im Gegensatz zu HuggieBot und Hera verfügt Max über keine spezielle Hardware, so dass seine haptische Wahrnehmung auf die Beschleunigungssensoren beschränkt ist, die in seinen beiden Greifern eingebaut sind. Kuchenbeckers frühere Doktorandin Naomi Fitter hatte die Idee, diese Greifer mit weichen Schlagpolstern zu bedecken und den Roboter so zu programmieren, dass er sehr empfindlich auf die Kontakte reagiert, die bei Klatschspielen auftreten. Schon diese einfache Form des Tastsinns beeindruckte die jüngeren und älteren Erwachsenen, die Max im Rahmen einer Laborstudie testeten: Sie sollten unter anderem die Spiele bewerten, in denen sie den Roboter berührten und in denen sie nur auf Abstand mit ihm trainierten. Dabei stellte sich heraus, dass die Teilnehmer die Spiele mit Berührungen wesentlich unterhaltsamer fanden.

Die Roboter mit Tastsinn aus Kuchenbeckers Labor sind Beispiele dafür, welche Fortschritte die Haptik inzwischen gemacht hat und welche Möglichkeiten diese Technik für die Interaktion zwischen Menschen und Maschinen bietet. Wenn es um die Digitalisierung von sozialen und gesundheitsbezogenen Leistungen geht, stellen sich neben Fragen der technischen Machbarkeit jedoch auch Fragen des Datenschutzes und der Ethik. Hera etwa könnte als Begleiter für Kinder mit Autismus unzählige Daten über das Verhalten seiner menschlichen Partner sammeln. Für wen sollen diese Daten zugänglich sein? Für die Eltern, den Therapeuten, die Krankenkasse? Und wird das Kind darüber aufgeklärt, dass sein neuer Freund all diese Daten weitergibt? Ähnliche Fragen stellen sich auch bei Robotern in der Pflege. Der deutsche Ethikrat positioniert sich hier klar und empfiehlt, dass der Einsatz von Robotik an den Zielen guter Pflege und Assistenz auszurichten ist. Dabei sei die Individualität der zu betreuenden Person zu respektieren und beispielsweise besonders auf Selbstbestimmung und Privatheit zu achten. Zudem sei es wichtig, dass der Roboter keine menschliche Pflege ersetzt und somit weder soziale Kontakte noch menschliche Interaktionen reduziert. Vielmehr sollte der Roboter nur als Ergänzung und gewinnbringend sowohl für Pflegende als auch für Gepflegte eingesetzt werden. Bei all diesen Überlegungen ist es außerdem wichtig, die Kosten zu berücksichtigen und Alternativen abzuwägen. Denn Roboter, die mit Menschen feinfühlig umgehen, werden zumindest anfangs teuer sein und nur stark begrenzte Aufgaben übernehmen. Für Kuchenbecker ist trotzdem klar, dass derartige Systeme Menschen künftig helfen könnten. Denn Roboter sind Teil unserer physischen Welt und können in vertrauter Art und Weise mit uns interagieren. Durch ihre Forschung verschiebt sie aktuell die Grenze des Machbaren, indem sie haptisch immer intelligentere Systeme entwickelt. Alles Weitere müssen wir als Gesellschaft aushandeln.

Auf den Punkt gebracht

Forschende des Max-Planck-Instituts für Intelligente Systeme untersuchen, welche Anforderungen Roboter erfüllen müssen, damit Menschen ihre Berührungen etwa bei therapeutischen oder sozialen Interaktionen als angenehm und hilfreich empfinden. Dafür nutzen sie unter anderem HuggieBot, einen Roboter, der Menschen umarmt.

Auf der Basis der entsprechenden Studien entwickeln und optimieren sie neben HuggieBot weitere technische Systeme mit einem Tastsinn: So können Kinder mit Autismus durch die Hilfe von Hera lernen, Menschen angemessen zu berühren. Max kann das Training von älteren Personen oder Menschen in einer Rehabilitationsmaßnahme unterstützen.

Der Einsatz von Robotern für therapeutische oder soziale Aufgaben wirft ethische und datenschutzrechtliche Fragen auf. Für welche Zwecke sie letztlich eingesetzt werden, muss die Gesellschaft daher in einer interdisziplinären Debatte klären.