Regeln für Roboter

Künstliche Intelligenz gewinnt an Bedeutung und rückt immer näher, auch buchstäblich: Pflegeroboter könnten demnächst bei uns zu Hause einziehen. Wie sie sich dabei verhalten sollen, ist noch nicht verhandelt. Am Max-Planck-Institut für Innovation und Wettbewerb in München beschäftigt sich Axel Walz mit der Frage, wie man mit rechtlichen Mitteln dazu beitragen kann, dass künstliche Intelligenz sich an menschliche Werte hält.

Text: Sarah Mühlberger

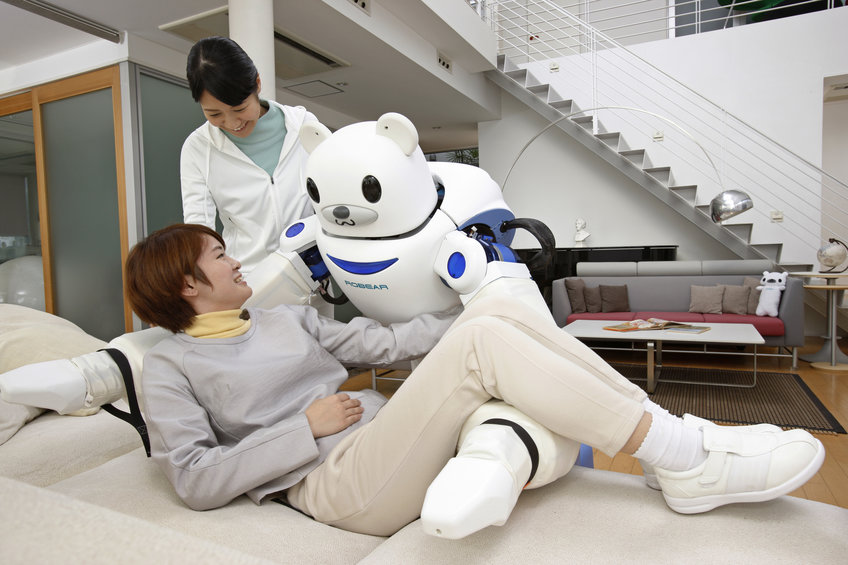

Sie bringen das Essen und erinnern an die Medikamenteneinnahme, sie helfen beim Duschen und schlagen die Bettdecke zurück. Manche von ihnen erzählen Witze, andere singen oder spielen Memory. Sie heißen Pepper, Justin, Riba oder Garmi - und sind möglicherweise die Zukunft in deutschen Pflegeheimen: die Roboter, die landauf und landab getestet werden.

Noch weiß niemand, ob sie das Pflegesystem tatsächlich eines Tages deutlich entlasten können – schließlich fehlen bereits heute mehr als 36.000 Pflegekräfte –, gleichzeitig ist das eine der harmloseren Fragen. Wem gehorcht der Pflegeroboter in letzter Konsequenz? Wird er den Patienten entmündigen oder haben doch die individuellen Vorstellungen des Menschen Vorrang? Wie kann sichergestellt sein, dass Pflegeroboter nicht gehackt werden? Schließlich verfügen sie über die sensibelsten aller personenbezogenen Daten, wissen über Gesundheit und Gewohnheiten eines Pflegebedürftigen Bescheid.

Solche Fragen müssen dringend geklärt werden, findet Axel Walz, Senior Research Fellow am Max-Planck-Institut für Innovation und Wettbewerb. Als Jurist hat ihn schon immer die Frage angetrieben, welche Folgen Innovationen für die Verbraucher haben. “In einer Zeit, in der künstliche Intelligenz und autonome Systeme an Bedeutung gewinnen, beschäftigt mich vor allem, wie man als Rechtswissenschaftler dazu beitragen kann, dass künstliche Intelligenz sich an ethische Maßgaben hält.”

“Ethik” ist dabei ein komplexer Begriff, der vieles meint: Individuelle Wertvorstellungen, religiöse Normen, gesetzlich verankerte Werte bis hin zum Schutz der Menschenwürde. “Es geht um das Prinzip der ethischen Pluralität”, sagt Walz.

Deswegen brauche es einen ganzen Maßnahmenmix: Man müsse auf der Grundlage eines abgestuften Regulierungsmodells denken und bei jedem Anwendungsfall genau prüfen, inwieweit das Recht durch Regulierung oder durch andere Anreize dazu beitragen kann, dass ethische Aspekte gewahrt werden. Für den Schutz menschlichen Lebens und menschlicher Würde sei zwingend die Gesetzgebung verantwortlich. Bestehende Gesetze müssten überprüft und gegebenenfalls an die Besonderheiten künstlicher Intelligenz angepasst werden. “Und wenn ich bei einem technologischen Produkt besondere, individuelle Maßstäbe setzen will, dann ist ein Vertrag zwischen zwei Partnern das idealtypische Regulierungsinstrument. Dort kann ich einen strikten Bedingungskatalog nach meinen Vorstellungen definieren.”

Um sicherzustellen, dass technische Produkte besondere Rücksicht auf die Werte einer bestimmten Personengruppe nehmen - hier denkt Walz etwa an Religionsgemeinschaften - seien Zertifikate eine gute Lösung. So wäre für jüdische Verbraucher sichergestellt, dass ihr smarter Kühlschrank nur Lebensmittel aus koscheren Supermärkten bestellt und für muslimische Patienten, dass ihnen der Roboter nur Medikamente reicht, die halal sind.

Überprüft werden könnten solche Zertifikatslösungen beispielsweise durch Einrichtungen wie den TÜV, „wie es teilweise schon heute passiert, etwa bei Datenschutzstandards“, sagt Walz. Spürbare Haftungsfolgen wären zudem eine Möglichkeit, die Hersteller zu disziplinieren, sollten ihre Systeme gehackt werden.

Axel Walz spricht für seine Forschung mit Entwicklern neuer Technologien und mit potenziellen Anwendern. Im nächsten Schritt schaut er sich die geltende gesetzliche Rechtslage an. “Und vor diesem Hintergrund versuchen wir dann eine Art Risikobewertung: Was sind die Vorteile einer neuen Technologie und welche möglicherweise negativen Auswirkungen stehen dem gegenüber?” Vor diesem Hintergrund lässt sich dann beurteilen, ob Regulierungsbedarf besteht.

Am Beispiel Pflegeroboter zeige sich besonders eindrücklich, wie wichtig eine Diskussion über ethische Werte ist – schließlich kommt eine derartige Technologie dem Menschen besonders nahe und betrifft ihn in seinem Intimbereich. So mancher versucht bereits jetzt, sich mit einer speziellen Patientenverfügung gegen den Einsatz von pflegenden Robotern zu wehren.

Noch sind die jedoch Zukunftsmusik, zumindest, wenn man sie sich als intelligente Helfer vorstellt, die eine Pflegekraft weitgehend ersetzen können. Testweise eingesetzt werden robotisierte Assistenzsysteme, die jeweils nur einzelne Funktionen übernehmen können: zum Beispiel Menschen mit Handicap beim Kochen, Putzen oder Einkaufen helfen oder Pflegekräfte beim Heben und Duschen von Patienten unterstützen.

“Grundsätzlich machen die Aufgaben, die derzeit von robotischen Systemen übernommen werden könnten, nur einen sehr kleinen Teil des Pflegeprozesses aus“, sagt Patrick Jahn, Leiter der Pflegeforschung am Universitätsklinikum Halle. „Sie würden im Alltag noch nicht zu der Art Entlastung für die Pflegenden führen, die allgemein erwartet wird.” Die meisten Modelle haben bislang ausschließlich Projektcharakter; von der Markteinführung sind sie weit entfernt.

Am weitesten entwickelt sind laut Jahn momentan die humanoiden Roboter, die auf Kommunikation, Unterhaltung und Information spezialisiert sind. In Nordrhein-Westfalen spielen “Robbie” und “Paula” mit den Bewohnern eines Pflegeheims Spiele oder fordern sie zu Gymnastikübungen auf. Andernorts wird “Paro”, eine Roboter-Robbe, die auf Streicheln reagiert, in der Pflege dementer Patienten eingesetzt. Und in Garmisch-Patenkirchen ziehen noch in diesem Jahr die Pflegeroboter “Justin” und “Edan” in ein Seniorenheim, um den Bewohnern Getränke oder Medikamente zu reichen, um ihnen die Bettdecke zurückzuschlagen und den Aufzugsknopf zu drücken, aber auch, um Alarm auszulösen, wenn ein Pflegebedürftiger stürzt.

In Halle suchen und entwickeln Pflegewissenschaftler, Mediziner und Informatiker im Rahmen des FORMAT-Projekts nach Einsatzszenarien für robotische Systeme, die schon heute einen Mehrwert bieten können. Schließlich sei auch ein Roboter, der ältere Menschen “nur” unterhält, eine Hilfe für Pflegekräfte, wenn angespannte oder aggressive Patienten dadurch entspannter werden, sagt FORMAT-Projektleiter Patrick Jahn.

Ein Beispiel ist “Pepper”: Die 1,20 Meter große Figur mit schwarzen Kulleraugen und Monitor vor der Brust ist derzeit im Einsatz, um Patienten in einem informativen Gespräch auf eine MRT-Untersuchung vorzubereiten. Auf diese Weise sparen Ärzte und Pflegekräfte Zeit. Auf dem heutigen Stand der Technologie wäre es auch möglich, dass der Roboter Pflegebedürftige über ihre Untersuchungstermine informiert und Angehörige zum Zimmer eines Patienten bringt, also ein Einsatz als robotische Stationshilfe. Beide Aufgaben sind in Workshops mit Pflegekräften entstanden. “Solche Einsatzszenarien sind auch deswegen wichtig, weil es an konkreten und überzeugenden Anwendungsbeispielen bisher mangelt“, sagt Jahn.

Noch gibt es viele Einschränkungen, das System läuft noch nicht stabil. Eine zu laute Umgebung kann die Kommunikation stören, weil Pepper dann nicht mehr gut genug versteht, was sein menschliches Gegenüber sagt. Und auch das dynamische Umfeld eines Krankenhauses bringt den Roboter durcheinander, etwa wenn plötzlich Betten auf dem Flur einer Station stehen, die dort am Vortag nicht standen - schon ist Peppers Orientierung überfordert.

FORMAT arbeite nach dem “Bertha-Benz-Prinzip”, erzählt Patrick Jahn: Die Automobilpionierin habe auch nicht gewartet, bis das neue Fortbewegungsmittel irgendwann mit 100 Stundenkilometern und ohne Probleme fahren konnte, sondern legte irgendwann einfach los. Bereits bei ihrer ersten Überlandfahrt entdeckte Benz weitere wichtige Voraussetzungen, etwa die Bedeutung von Tankstellen; erst mit ihrem Praxistest verhalf sie der neuen Technik zum Durchbruch.

Dieser Ansatz lasse sich gut auf den Einsatz robotischer Systeme in der Pflegehilfe übertragen, findet Jahn: „Auch wenn wir noch weit weg sind von der Vision, die alle im Kopf haben - dem intelligenten Helfer, der die Pflegekräfte deutlich entlastet -, müssen wir mit den Einschränkungen arbeiten, um die schnelle Integration in die Praxis zu schaffen. Sonst kommt die Entwicklungsdynamik nicht in Gang.”

Axel Walz findet, dass Deutschland an der Entwicklung künstlicher Intelligenz beteiligt sein sollte. “Gleichzeitig müssen wir dafür Sorge tragen, dass wir eine qualitativ nachhaltige, hochwertige Artificial Intelligence entwickeln, die entsprechenden ethischen Kriterien genügt.” Die normative Zielrichtung müsse seiner Ansicht nach eine humane Gesellschaft sein, die zu ihren etablierten Werten steht und die Technik dafür nutzt, diese Werte weiter zu unterstützen - und sie keinesfalls zu entmenschlichen.

Walz wünscht sich eine offene Debatte, in der auch diskutiert wird, “ob und wo möglicherweise rote Linien verlaufen. Also: Inwieweit darf ich bestimmte Produkte überhaupt mit künstlicher Intelligenz ausstatten?” Dass solche Fragen bislang kaum breiter diskutiert werden, liegt laut Walz auch an der Technikgläubigkeit des Menschen. “Wenn wir das Gefühl haben, Dinge sind so komplex, dass wir sie nicht verstehen, dann hat man psychologisch die Tendenz, ihnen blind Glauben zu schenken und sie über die eigene Entscheidungskompetenz zu stellen. Wir sind in dieser Hinsicht zu wenig selbstbewusst und halten Algorithmen für objektiver und neutraler als Menschen.“ Tatsächlich sei das Gegenteil der Fall, „denn Algorithmen werden mit Daten trainiert und die Auswahl dieser Daten wird von der Voreingenommenheit des Programmierers geprägt”, erklärt Walz.

Bei künstlicher Intelligenz komme erschwerend das Blackbox-Phänomen hinzu. Ein traditioneller Algorithmus funktioniert, indem man Daten hineingibt und am Ende ein Ergebnis herauskommt, typischerweise nach einem klassischen Wenn-Dann-Prinzip. Anders ist es bei künstlicher Intelligenz: Diese Algorithmen sind lernfähig, können also Informationen aufnehmen, auswerten und daraus Schlussfolgerungen ziehen. So können sie gewissermaßen qua eigener Erfahrung lernen. “Der Algorithmus ist also nicht statisch, sondern entwickelt sich selbst weiter. Was aber dabei genau passiert und warum, das ist offenbar nicht einmal den Programmierern selbst klar”, fasst Axel Walz zusammen.

Eine mögliche Antwort darauf könnte der Ansatz des weltweiten Ingenieursverbands IEEE sein, der eine weltweite Initiative für ethische Überlegungen bei der Entwicklung autonomer Systeme ins Leben gerufen hat. Neben theoretischer Grundlagenarbeit sollen dabei auch konkrete ethische Technologiestandards ausgearbeitet werden. Ein Ziel ist etwa ein sogenannter Transparenzstandard. “Er soll sicherstellen, dass Algorithmen für Künstliche Intelligenz so programmiert werden, dass man jederzeit nachvollziehen kann, welche Daten verwendet worden sind und warum ein bestimmtes Ergebnis erzeugt worden ist”, erklärt Axel Walz, der sich regelmäßig mit der IEEE-Initiative austauscht.

Auch der Faktor Mensch ist bislang alles andere als hinreichend erforscht. Was macht es mit Arbeitnehmern, neben oder mit Robotern zu arbeiten?

Mit den Auswirkungen auf Pflegekräfte beschäftigt sich das interdisziplinäre Projekt “Orient”, das durch die EU-Initiative “More years, better lives” gefördert wird und an dem neben Innovationsforschern aus Finnland und Pflegewissenschaftlern aus Schweden auch Wirtschaftswissenschaftler aus Paderborn beteiligt sind. “Wir untersuchen, welche Voraussetzungen geschaffen werden müssen, damit Assistenzsysteme in der Pflege eingesetzt und akzeptiert werden ”, erläutert Kirsten Thommes, Professorin für Organizational Behavior an der Universität Paderborn.

In Zukunft müsse viel stärker auf die Bedürfnisse und Ansprüche derjenigen eingegangen werden, die direkt vom Einsatz der robotischen Systeme betroffen sind: der Pflegekräfte und Pflegebedürftigen also. “Bisher ist die Robotik sehr ingenieurlastig”, sagt Kirsten Thommes. Die Paderborner Wissenschaftler schauen auf die Bedürfnisse und Einstellungen der Pflegekräfte: Was müssen sie im Vorfeld über die Roboter wissen, was nicht? Müssen sich Ausbildungsinhalte verändern, künftige Pflegerinnen womöglich programmieren lernen? An welchen Stellen können Roboter entlasten? Wo gibt es mögliche Reibungspunkte? Ein Assistenzsystem, das der Pflegekraft entgegen ihrer Routine sagt, zu welchem Patienten sie zuerst gehen soll, greift schließlich deutlich in deren Kompetenzbereich ein. Außerdem, das zeigten Einzelfallstudien aus Japan, wo Pflegekräfte die Roboter ausschalteten oder in den Schrank sperrten, kann die permanente Aufzeichnung durch die Systeme leicht zu einem Gefühl der Überwachtwerdens führen.

“Es gibt noch keine Studien dazu, wie die durchschnittliche Pflegekraft auf die Assistenzsysteme blickt und welche Bedenken dabei verbreitet sind”, sagt Thommes. In der Bevölkerung generell gebe es aber eine gewisse Sorge vor dem Einsatz von Robotern. Eine Umfrage zeigte, dass mehr als 70 Prozent der Deutschen an den “Terminator” denken, wenn man sie nach ihrer Assoziation zum Stichwort Roboter befragt - die von Arnold Schwarzenegger verkörperte Maschine menschlichen Aussehens, aus dem gleichnamigen Film von 1984. “Ein solch negatives Image verringert natürlich die Bereitschaft, sich ernsthaft damit auseinanderzusetzen, dass robotische Systeme irgendwann eine große Hilfe und Entlastung sein könnten”, sagt Kirsten Thommes. “Nicht nur, aber eben auch mit Blick auf den Pflegenotstand.”

Wie Roboter und andere Technologien in Zukunft im Alltag helfen können, wird auch an der Berliner Charité erforscht. Die Arbeitsgruppe „Alter und Technik“ versteht sich dabei als Schnittstelle zwischen Zielgruppe und Technik, zwischen Pflegebedürftigen und Herstellern, erläutert Anika Steinert, die die Arbeitsgruppe leitet: “Wir übersetzen die jeweiligen Anforderungen und prüfen bei Evaluationen, was der Mehrwert einer Technologie ist, wie sie angenommen wird und wie sie sich anwenden lässt.“

Im Projekt “Robina” wird gerade ein Roboterarm für ALS-Patienten konzipiert, die kognitiv völlig klar sind, aber an Muskelschwund leiden. Als es im Vorfeld darum ging, zu definieren, wobei der Arm unterstützen sollte, hatten die teilnehmenden Patienten eher bescheidene Wünsche. “Mal kratzen”, zum Beispiel, kleinste Tätigkeiten, bei denen die ALS-Patienten am liebsten nicht jedes Mal um Hilfe rufen möchten.

Vor der Entwicklung stehen dann erst einmal viele Fragen: Wie soll der Arm aussehen? Soll er mobil sein oder irgendwo fest installiert? Wie soll er gesteuert werden, welches Design, welche Haptik soll er haben? Aber auch ethisch-rechtliche Fragen, “denn schon Kratzen ist eine sehr komplexe Anforderung”, erklärt Anika Steinert. Wie kann die Sicherheit von Patienten und Personal gewährleistet werden, wenn der Arm einem ja per Aufgabe sehr nahekommen muss? Was soll der Arm dürfen, was nicht? Darf er speichern, wie oft er gekratzt hat? Wie oft er Wasser gereicht hat? Und soll er von sich aus aktiv werden und ein Glas reichen, wenn ein Patient drei Stunden lang nichts getrunken hat? Oder nur reagieren, wenn er angesprochen oder gesteuert wird? “Es geht immer darum, einen guten Mittelweg zwischen dem Autonomiebedürfnis der Patienten und der Hilfestellung durch die Technologie zu finden”, sagt Steinert.

Bedenken habe es im Vorfeld nur wenige gegeben, “ALS-Patienten sind ja gewohnt, in ihrem Alltag auf Hilfsmittel angewiesen zu sein”. Zwar seien sie typischerweise deutlich jünger als Geriatrie-Patienten. “Aber die Ergebnisse des Projekts lassen sich auf viele Zielgruppen anwenden.” Oft sind es im Projekt die Pflegekräfte, die Sorgen formulieren, etwa weil sie aus ihrer Perspektive manchen Sicherheitsaspekt stärker gewichten. Bei der Zusammenarbeit mit den Herstellern stellen die Berliner Wissenschaftler oft fest, wie wenig Gespür es für ethische Aspekte rund um die Produkte gibt. Immerhin: „In den vergangenen Jahren hat das Thema deutlich an Bedeutung gewonnen“, sagt Anika Steinert, „solche Fragestellungen werden viel seltener belächelt als früher.“ Das liege auch am verstärkten Interesse, das die Politik an ethischen Standards für künstliche Intelligenz zeigt.

Axel Walz vom Max-Planck-Institut für Innovation und Wettbewerb sieht in diesen Standards eine wichtige mögliche Stellschraube auf dem Weg zu einer menschlichen digitalen Gesellschaft, die an etablierten humanen Grundwerten orientiert ist. “Ein ganz simpler Ansatzpunkt, um schon zu Beginn der Entwicklung einer neuen Technologie Einfluss zu nehmen, ist es, nur solche Projekte zu fördern, die mit dem entsprechenden Ethik-Katalog übereinstimmen.”

Dem Juristen ist es wichtig zu betonen, dass es nicht darum gehe, Innovation durch Regulierung zu hemmen, im Gegenteil: “Regulierungsinstrumente können dabei helfen, die Ängste und Sorgen in der Bevölkerung ernst zu nehmen und sogar abzubauen, wenn unsere bestehenden Standards auf neue Technologien übertragen werden. “Wir befinden uns mitten in einer massiven Revolution und müssen die Gesellschaft bei solch tiefgreifenden technologischen Entwicklungen mitnehmen.”

Walz selbst sieht beispielsweise keine Rechtfertigung für androide Roboter, das heißt solche Roboter, die möglichst menschliche Züge aufweisen. Zwar beziehe sich das Klonierungsverbot primär auf die biologische Reproduktion. “Sinn und Zweck des Verbots ist es aber, die Singularität menschlichen Lebens zu schützen. Und die sehe ich genauso bedroht, wenn jemand eine biomechanische Kopie erstellt.” Die damit einhergehende Objektivierung des Menschen würde klar gegen Artikel 1 des Grundgesetzes verstoßen.

Auch und insbesondere im Pflegebereich gebe es keinen Grund für den Einsatz androider Roboter, findet Walz. Pflegeroboter sollen menschliche Arbeitskräfte nicht ersetzen, sondern bestenfalls unterstützen. „Als Unterstützung im Pflegealltag, insbesondere im Rahmen wiederkehrender, mechanischer Tätigkeiten bieten Roboter eine große Chance mit Blick auf das Problem fehlender Fachkräfte, und dies bei gleichzeitiger Verbesserung der Pflegequalität.“ Dies setze allerdings voraus, die Roboter in Pflegeheimen so einzusetzen, dass das Personal dort mehr Zeit für persönliche Zuwendung hat, um sich in menschlicher Hinsicht besser um die Pflegebedürftigen kümmern zu können. „Es wäre eine menschliche Kapitulationserklärung, wenn wir eines Tages tatsächlich versuchen würden, Zuneigung und Empathie über Roboter zu transportieren“, sagt Axel Walz. „Die Achtung der menschlichen Würde sollte daher als oberstes Leitprinzip die Entwicklung und den Einsatz von Pflegerobotern prägen.“

Auf den Punkt gebracht:

Bereits bei der Entwicklung von Pflegerobotern sollten rechtliche und ethische Aspekte berücksichtigt werden, um den Bedürfnissen von Patienten und von Pflegekräften gerecht zu werden.

Pflegebedürftige müssen sicher sein, dass nicht mehr Daten als unbedingt nötig erfasst werden und diese geschützt sind. Zudem dürfen Roboter die Patienten nicht bevormunden.

Auch die Pflegenden müssen vor Überwachung geschützt werden; der Einsatz robotischer Systeme sollte sich auf wiederkehrende mechanische Tätigkeiten beschränken.

Ein rechtlicher Rahmen könnte helfen, die Akzeptanz für den Einsatz von Pflegerobotern zu stärken.