Forschungsbericht 2003 - Max-Planck-Institut für Kognitions- und Neurowissenschaften

Das Verstehen der Bedeutung von Musik

Music, Language and Meaning: Brain Signatures of Semantic Processing

Neurokognition der Musik (MPG) (Dr. Stefan Kölsch)

MPI für Kognitions- und Neurowissenschaften, Leipzig

Wenn ich einen Satz höre wie Hannah singt ein Lied erwarte ich das Wort Musik eher als das Wort Stift. Dieser Effekt ist der semantische Priming Effekt, er hat zur Folge, dass Wörter mit semantisch enger Relation zu einem vorhergehenden Kontext schneller und leichter verarbeitet werden als semantisch unverwandte Wörter.

Ein elektrophysiologischer Index semantischen Primings ist die N400-Komponente des ereigniskorrelierten elektrischen Hirnpotenzials (EKP; EKPs können mit elektroencephalographischen Methoden gemessen werden). Die N400 entsteht normalerweise um ca. 250-400 Millisekunden (ms) nach der Darbietung eines Wortes. Die durch Wörter evozierte N400 ist sensitiv für Manipulationen semantischer Relationen: Sie ist kleiner, wenn auf einen Satz wie Hannah singt ein Lied ein Wort mit enger semantischer Relation zu dem Satz folgt (z.B. Musik), und größer, wenn das Wort keinen semantischen Bezug zum Satz hat (z.B. Stift).

Semantik ist selbstverständlich eine basale Dimension der Sprache, und für viele Menschen ist der Gedanke ungewohnt, dass auch Musik semantische Informationen vermittelt. Musik ist jedoch in erster Linie Mittel der Kommunikation, und Komponisten nutzen Musik als Mittel des Ausdrucks. Theoretisch können unterschiedliche Aspekte musikalischer Semantik unterschieden werden. (1) Musikalische Semantik übermittelt durch Information, die an Objekte erinnert (z.B. an eine Spieluhr), oder musikalische Information, die Eigenschaften bezeichnet (z.B. hoch, hell, schnell). (2) Musikalische Semantik, die durch das Entstehen bzw. das Erkennen einer Stimmung vermittelt wird (z.B. fröhlich). (3) Bedeutung durch extramusikalische Assoziationen (z.B. eine Nationalhymne), und (4) Bedeutung, die durch das Arrangement formaler Strukturen entsteht (z.B. Überraschung durch einen unerwarteten Akkord).

Intuitiv scheint es plausibel, dass auch Musik semantische Information übermitteln kann: Bei bestimmten Passagen von Beethoven-Symphonien z.B. denken wir eher an Held als an Floh, und bei bestimmten Passagen von Mozart-Symphonien denken wir eher an Engel als an Flegel. Es war bisher jedoch unklar, wie es zu solchen semantischen Assoziationen beim Hören von Musik kommt, und ob die kognitiven Mechanismen, die beim Hören von Musik semantische Informationen entschlüsseln diejenigen Mechanismen sind, die auch der Verarbeitung sprachlicher Semantik dienen.

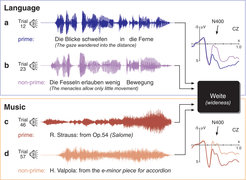

Wir führten ein semantisches Priming-Experiment durch, in dem (a) Sätze sowie (b) kurze musikalische Exzerpte als Prime-Stimuli präsentiert wurden (die Exzerpte wurden von normalen Musik-CDs aufgenommen). Diese Prime-Stimuli hatten semantisch entweder einen starken, oder einen schwachen Bezug zu einem Zielwort (Abb. 1, in dem Beispiel der Abbildung hat das Zielwort Weite einen starken semantischen Bezug zum Satz Die Blicke schweifen in die Ferne, und einen schwachen Bezug zum Satz Die Fesseln erlauben wenig Bewegung). Zielwörter waren 44 Wörter (z.B. Illusion, Weite, Keller, König, Nadel, Treppe, Fluss, Mann), die Hälfte der Wörter waren konkrete Wörter, die andere Hälfte abstrakte Wörter.

Die musikalischen Prime-Stimuli wurden aufgrund musik-theoretischer Terminologie, oder aufgrund von Aussagen von Komponisten über ihre Stücke ausgewählt. Z.B. war der musikalische Prime-Stimulus für das Wort Nadel eine Passage aus einem Streichterzett von A. Schönberg, in dem Schönberg Stiche während seiner Herzattacke beschrieb. In dem Exzerpt von R. Strauss aus Abbildung 1 sind die Akkorde in weiter Lage gesetzt (die Töne umfassen also ein weites Frequenzspektrum), daher wurde dieses Exzerpt als Prime-Stimulus für das Wort Weite benutzt.

Einige der musikalischen Prime-Stimuli erinnerten an Klänge von Objekten (z.B. Vogel), oder an Objektqualitäten (z.B. tiefe Töne und Keller, aufsteigende Intervallstufen und Treppe). Andere musikalische Prime-Stimuli (besonders diejenigen für abstrakte Wörter) erinnerten an prosodische und gestische Merkmale, die mit bestimmten Wörtern assoziiert sind (z.B. Seufzer, Trost). Außerdem wurden musikalische Prime-Stimuli eingesetzt, die stereotypische musikalische Stile und Formen repräsentieren, die üblicherweise mit bestimmten Wörtern assoziiert werden (z.B. ein Kirchenchoral und das Wort Andacht).

Abbildung 1 (rechts oben) zeigt die EKPs, die durch Zielwörter evoziert wurden, die entweder eine starke (braune Linie) oder schwache (lilafarbene Linie) semantische Relation zu einem Prime-Satz hatten. Verglichen mit passenden Wörtern evozierten semantisch unpassende Wörter eine deutliche N400-Komponente. Dieser Befund repliziert den klassischen semantischen Priming-Effekt (bei dem Wörter, die semantisch nicht zum vorhergehenden Kontext passen, ein N400-Potenzial evozieren). Der Effekt reflektiert, dass kognitive Prozesse semantischer Verarbeitung abhängig waren vom Grad der semantischen Relation zwischen Zielwort und vorhergehendem Satz.

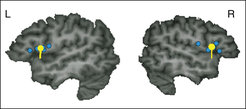

Der untere Teil von Abbildung 1 (rechts) zeigt EKPs, die durch Zielwörter evoziert wurden, die entweder eine starke (dunkelblaue Linie) oder schwache (hellblaue Linie) semantische Relation zu einem musikalischen Prime-Stimulus hatten. Erstaunlicherweise evozierten Wörter, die semantisch nicht zu dem vorhergehenden musikalischen Exzerpt passten, ebenfalls eine deutliche N400 (verglichen mit Wörtern, die semantisch zum vorergehenden musikalischen Kontext passten). Der N400-Effekt unterschied sich nicht zwischen der Sprach-Bedingung (in der die Zielwörter den Sätzen folgten) und der Musik-Bedingung (in der die Zielwörter der Musik folgten): Der Unterschied zwischen den Potenzialen evoziert durch semantisch passende und unpassende Wörter hatte den gleichen Amplituden-Wert, die gleiche Latenz, und die gleiche Schädelverteilung in der Sprach- wie in der Musik-Bedingung. Abbildung 2 zeigt die Ergebnisse von Quell-Lokalisationen der N400-Effekte. Die neuronalen Generatoren der N400 unterschieden sich nicht zwischen der Sprach-Bedingung (Abb. 2 oben, braune Dipole) und der Musik-Bedinung (Abb. 2 unten, blaue Dipole). In beiden Bedingungen wurden die primären Quellen der N400 bilateral im posterioren Anteil des Gyrus temporalis medius lokalisiert (Brodmann-Areale 21/37); diese Regionen sind bekannt für die Verarbeitung semantischer Information während der Perzeption von Sprache.

Der N400-Effekt in der Musik-Bedingung zeigt, dass musikalische Information einen systematischen Einfluss auf die semantische Verarbeitung von Wörtern haben kann. Der Befund, dass sich der N400-Effekt nicht zwischen Sprach- und Musikbedingung unterscheidet, zeigt, dass musikalische Information dieselben Effekte auf semantische Verarbeitungsprozesse haben kann wie sprachliche Information. D.h. die Daten demonstrieren, dass Musik Repräsentationen semantischer Konzepte aktivieren kann, und dass daher Musik erheblich mehr semantische Information vermitteln kann als bisher angenommen.

Der N400-Effekt wurde sowohl bei abstrakten als auch bei konkreten Wörtern beobachtet, was bedeutet, dass Musik abstrakte wie konkrete semantische Information vermitteln kann. Außerdem wurde der Effekt auch unabhängig von emotionalen Beziehungen zwischen Prime-Stimuli und Zielwörtern gemessen, was bedeutet, dass Musik nicht nur emotionale Information vermitteln kann.

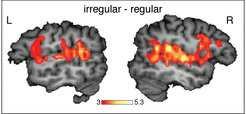

Die vorliegenden Befunde stützten die Annahme, dass das menschliche Gehirn Musik und Sprache teilweise mit denselben kognitiven Prozessen, und in denselben Strukturen des Gehirns verarbeitet. Diese Annahme basiert auf Ergebnissen vorhergehender Studien, die zeigen, dass auch musikalische Syntax vom Gehirn ähnlich wie sprachliche Syntax verarbeitet wird. Mit magnetencephalographischen Methoden (MEG) haben wir entdeckt, dass ein musik-syntaktisch irregulärer Akkord in Arealen des Gehirns verarbeitet wird, die auch der Verarbeitung sprachlicher Syntax dienen (Abb. 3, in der linken Hemisphäre wird das Areal, in dem sich der Dipol befindet, auch als Broca-Areal bezeichnet). Mit funktioneller Magnetresonanztomographie (fMRT) konnten wir zeigen, dass die Verarbeitung unerwarteter Akkorde im Gehirn nicht nur das Broca-Areal (und das homotope Areal in der rechten Hemisphäre) aktiviert, sondern auch posterior-temporale Areale (Abb. 4). Diese Areale werden in der linken Hemisphäre oft auch als Wernicke-Region bezeichnet. Sowohl Broca-Areal als auch Wernicke-Region sind von entscheidender Bedeutung für die Perzeption und Produktion von Sprache; das Zusammenspiel dieser beiden Regionen wurde lange Zeit als sprachspezifisch angenommen. Die Daten aus Abb. 4 zeigen erstmals, dass dieses kortikale "Sprachnetzwerk" auch der Verarbeitung von Musik dient (im Bereich der Sprache ist dieses Netzwerk oft links-hemisphärisch lateralisiert, im Musik-Experiment war es leicht rechts-lateralisiert).

Die hier vorgestellten Befunde indizieren, dass das menschliche Gehirn oft keinen wesentlichen Unterschied zwischen musikalischer und sprachlicher Information macht - oder anders gesagt: dass für das Gehirn oft Musik Sprache bzw. Sprache Musik ist. Der Befund eines musik-sprachlichen neuronalen Netzwerkes erklärt auch, warum musikalische Elemente der Sprache bereits sehr früh im Verlauf der Sprachakquisition von großer Wichtigkeit sind: Es wird angenommen, (a) dass Musik und Sprache in frühen Stadien der Sprachentwicklung sehr eng miteinander verbunden sind, (b) dass musikalische Elemente der Sprache den Weg zu linguistischen Kompetenzen früher bereiten als phonetische Elemente, und (c) dass melodische Aspekte der Erwachsenen-Sprache für Babies deren früheste Assoziationen sowohl zwischen Klangmustern und semantischer Bedeutung, als auch zwischen Klangmustern und syntaktischer Struktur repräsentieren. Nicht zu vergessen spricht ein Grossteil der Erdbevölkerung Tonsprachen, d.h. Sprachen, in denen die Semantik eines Wortes auch durch Sprechmelodie vermittelt wird. Auch in nicht-tonsprachlichen Sprachen ist die Prosodie (d.h. die musikalische Information der Sprache, z.B. Melodie und Metrum), von großer Bedeutung für das Verständnis gesprochener Sprache.

Interessanterweise waren alle Versuchspersonen der hier vorgestellten Studien so genannte "Nichtmusiker" (d.h. Menschen ohne formelles musikalisches Training). Dies zeigt, dass auch Menschen ohne explizites musik-theoretisches Wissen und ohne spezielles musikalisches Training musikalische Syntax verarbeiten und musikalische Semantik verstehen können. Das (implizite) musikalische Wissen wird vermutlich durch alltägliche Hörerfahrungen akquiriert. Diese Annahmen stimmen mit Studien überein, die zeigen, dass die Akquisition musikalischen Wissens, und die Verarbeitung musikalischer Information entsprechend dieses Wissens eine allgemeine menschliche Fähigkeit ist. Diese allgemeine menschliche Musikalität war phylogenetisch vermutlich von großer Bedeutung für die Entwicklung von Sprache, und hatte wichtige soziale Funktionen wie z.B. Erleben von Gemeinschaft und Koordination kooperativer Handlungen. In diesem Sinne zeugt die menschliche Musikalität auch von der besonderen biologischen Relevanz von Musik.