Forschungsbericht 2022 - Max-Planck-Institut für Intelligente Systeme, Standort Stuttgart

Fingerspitzengefühl für Roboter

Die Robotik ist eines der dynamischsten Forschungsfelder überhaupt. Roboter nehmen ihre Umgebung immer besser wahr, fast so gut wie wir Menschen. Computer laufen über Hindernisse, ohne zu stolpern, sie servieren Essen in Restaurants, sie reichen ein Glas Wasser oder heben Heruntergefallenes auf. Diese intelligenten Maschinen haben künstliche Augen und Ohren, doch alle anderen Sinne liegen brach. Ein Tastsinn zum Beispiel ist meist nicht eingebaut, da er schwer künstlich nachzuahmen ist. Doch ohne zu fühlen werden Roboter nie zu Partner werden, die uns Menschen im Alltag unterstützen. Ihre Wahrnehmung wird unserer immer um einiges nachstehen.

In einer Forschungsarbeit, die im Fachjournal Nature Machine Intelligence veröffentlicht wurde, gingen wir die Herausforderung an, das Gefühl in den Fingerspitzen von Robotern künstlich nachzubilden.

Wie sein natürliches Vorbild ist der Fingersensor sehr empfindlich

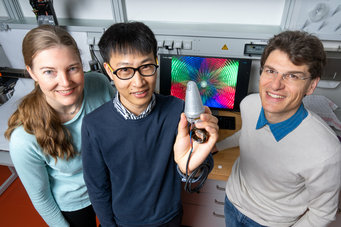

Unser Team am Max-Planck-Institut für Intelligente Systeme entwickelte einen robusten, weichen und haptischen Sensor und tauften ihn „Insight“. Mit Hilfe von Maschinellem Sehen und einem tiefen neuronalen Netz kann unser Sensor genau abschätzen, an welcher Stelle Objekte mit ihm in Kontakt kommen und wie groß die einwirkenden Kräfte sind. Wie sein natürliches Vorbild ist der Sensor sehr empfindlich, robust und präzise. Das Forschungsprojekt ist ein wichtiger Schritt hin zu Robotern, die wie Tiere und wir Menschen unsere Umgebung ertasten können.

Der einem Daumen nachempfundene Sensor besteht aus einer weichen Hülle, die ein leichtes, steifes Skelett in sich einschließt. Dieses Skelett hält die Struktur aufrecht, ähnlich wie Knochen das weiche Gewebe eines Fingers stabilisieren. Die Hülle besteht aus einem Elastomer, das wir mit dunklen, aber reflektierenden Aluminiumflocken anmischten. Dadurch bekommt die Hülle eine gräuliche Farbe und ist undurchsichtig, sodass kein Licht von außen eindringen kann. Im Inneren dieser fingergroßen Kapsel bauten wir eine winzige 160-Grad-Fischaugenkamera ein. Sie nimmt bunte Lichtmuster auf, die von einem Ring aus LEDs erzeugt werden.

Wird die Sensorhülle berührt, ändert sich das Farbmuster

Wenn ein oder mehrere Objekte die Hülle berühren, ändert sich das Farbmuster im Inneren des Sensors. Die Kamera nimmt mehrmals pro Sekunde Bilder auf und füttert mit diesen Daten ein tiefes neuronales Netz. Unserem Algorithmus entgeht dabei nichts: in jedem Pixel erkennt er selbst kleinste Veränderung des Lichts und damit Verformungen der Oberfläche. Innerhalb eines Sekundenbruchteils kann das trainierte Netz herausfinden, wo genau ein Objekt unseren Finger berührt, wie stark die Kräfte sind und in welche Richtung sie wirken. Diese Information wird als Kraftmuster – auf Englisch force map genannt – dargestellt: ein dreidimensionales Abbild der Kräfte, die auf den künstlichen Daumen einwirken.

In der Tat zeigt der Sensor eine hervorragende Sinnesleistung. Zu diesem Erfolg haben alle Aspekte des Sensors beigetragen. Die weiche mechanische Hülle mit dem eingebetteten Skelet sorgt für hohe Empfindlichkeit, aber auch dafür, dass man den Finger kräftig drücken kann. Das Kamerasystem ist so optimiert, dass die Verformung von einem einzigen Bild optimal abgeleitet werden kann. Mit einem speziell dafür entwickelten automatisierten Stimulationssystem konnten genug Daten gesammelt werden, um das tiefe Netz zu trainieren. Bisherige Sensoren hatten nur einen kleinen Bereich, in dem sie Dinge erfassen konnten. Sie waren empfindlich und schwierig herzustellen und konnten oft keine Schwerkräfte spüren. Diese sind aber für einen Roboter unerlässlich, um z.B. sicher ein Glas Wasser abzustellen oder eine Münze auf einem Tisch verschieben zu können.

Stab stupst den Sensor über 200.000 mal

Doch wie genau lernt der Sensor, was ihn berührt? Wir entwarfen einen Versuchsaufbau, um Trainingsdaten zu sammeln. Diese Daten benötigt das maschinelle Lernverfahren, um die Korrelation zwischen der Veränderung der Bildpixel und den angewandten Kräften zu verstehen. Wir nahmen einen Stab, der den Sensor überall auf seiner Oberfläche immer wieder stupst. Der Computer zeichnet diese Krafteinwirkung zusammen mit dem Kamerabild im Inneren des Sensors auf. So erzeugten wir etwa 200.000 Messungen. Es dauerte fast drei Wochen, um die Daten zu sammeln und einen weiteren Tag, um den Deep Learning Algorithmus zu trainieren. Der Daumen überstand dieses lange Experiment mit vielen verschiedenen Krafteinwirkungen – ein Beleg für die Robustheit des mechanischen Designs von Insight.

Künstlicher Fingernagel noch empfindlicher als der Rest des Sensors

Eine weitere Besonderheit des daumenförmigen Sensors ist, dass es einen Bereich mit einer dünneren Elastomer-Schicht gibt, die einem Fingernagel nachempfunden ist. Dieses Grübchen ist so konzipiert, dass es selbst kleinste Kräfte und verschiedene Objektformen erkennen kann. Für diese sehr empfindliche Zone wählten wir eine Materialdicke von 1,2 mm statt der 4 mm, die wir ansonsten für den Fingersensor verwendeten.

Das Hard- und Softwaredesign, das wir in unserer Arbeit vorstellen, lässt sich auf eine Vielzahl von Anwendungsfällen mit unterschiedlichen Formen und Präzisionsanforderungen übertragen. Die Programmierung des Deep Learning Algorithmus, die Datenerfassung, das Training des Netzes und was das System daraus ableitet, sind allgemeingültig und können helfen, viele andere Sensoren zu entwickeln. Unsere Erfindung verbessert die haptische Wahrnehmung von Roboterfingern erheblich und kommt dem Tastsinn der menschlichen Haut einen wesentlichen Schritt näher.

Literaturhinweise

Nature Machine Intelligence, 4(2):135-145, February 2022

Science Robotics, 7, pages: eabm0608, February 2022

Robotics and Autonomous Systems (RAS), 2015