Roboter machen Schule

Als Haushaltshilfe, Pflegeassistent oder Katastrophenschützer taugen Roboter nur, wenn sie lernfähig sind und zumindest ansatzweise selbstständig handeln können. Forscher des Max-Planck-Instituts für Intelligente Systeme in Tübingen bringen den Maschinen die dafür nötige Flexibilität und Autonomie bei.

Text: Peter Hergersberg

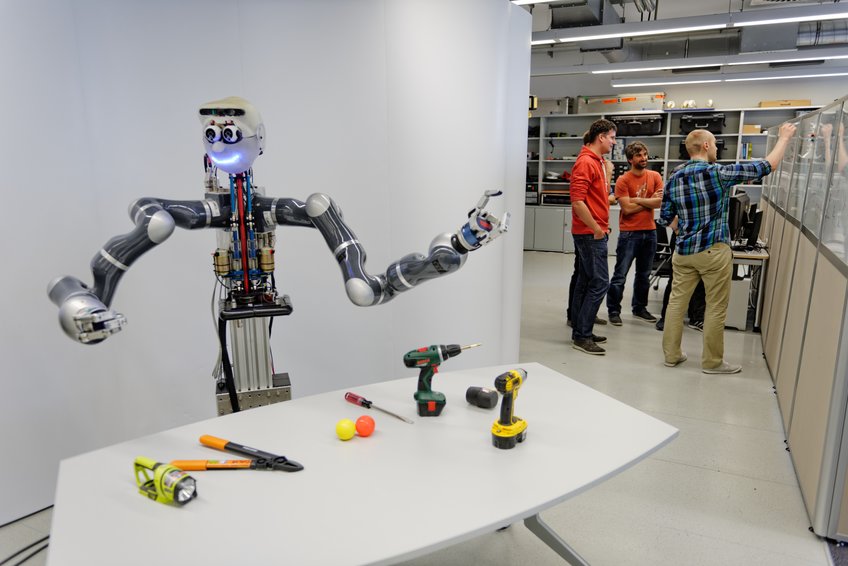

Einem griechischen Gott ähnelt Apollo eher entfernt. Sein treuherziger Blick aus den großen Kulleraugen erinnert mehr an Shaun, das Schaf, als an einen Unsterblichen, der mit seinen Widersachern gar nicht zimperlich umging. Auch taugt der Apollo aus dem Labor des Max-Planck-Instituts für Intelligente Systeme allenfalls als Halbgott, denn sein Oberkörper ruht auf einer massiven Säule statt auf einem göttlichen Unterleib. Und die Taten, die er vollbringt, gehören, nun ja, eher zu den leichteren göttlichen Aufgaben: Wenn es gut geht, kann er diverse Gegenstände sicher greifen, einen Stab auf der Hand balancieren oder sogar ein Rad auf einer Achse montieren.

Für einen Gott mag das wenig sein, aber der Apollo im Labor des Tübinger Max-Planck-Instituts für Intelligente Systeme ist ein Roboter. Und für einen Roboter kann er erstaunlich viel. Vor allem lernt er, und zwar auf eine Weise, die es ihm oder besser seinen zweibeinigen Nachfahren einmal ermöglichen könnte, sich in einer unbekannten Umgebung autonom zu bewegen und selbstständig diffizile Aufgaben zu erledigen.

Die Lernfähigkeit braucht ein Roboter, wenn er etwa als Katastrophenhelfer in einer havarierten Industrieanlage einen Schaden beheben oder verletzte Personen bergen soll und dabei auf ein unerwartetes Hindernis stößt, über das er klettern muss. Auch als Haushaltshilfe oder gar als Pflegeassistent müsste sich ein Roboter immer wieder auf neue Situationen und unvorhergesehene Ereignisse einstellen.

Zu der dafür nötigen Autonomie wollen Forscher des Tübinger Max-Planck-Instituts den Maschinenwesen verhelfen. Wie weit der Weg dahin noch ist, demonstriert ein Video der Darpa Robotics Challenge. Bei diesem Wettbewerb müssen Roboter mit einem Golfmobil fahren und durch Sand gehen, um ein Gebäude zu erreichen, in dem sie ein Ventil zudrehen sollen. Man sieht aber vor allem eins: Wie Rettungsmaschinen, begleitet von heroisch stimmender Musik, variantenreich stürzen. Wenn sie aus dem Golfwagen steigen, wenn sie über den Sandweg wanken oder wenn sie - statt die Tür zu ihrem Ziel aufzudrücken - sich selbst aus dem Gleichgewicht schieben.

Heute scheitern Roboter in ungewohntem Terrain noch meist, weil sie im Wortsinn einfältig sind. Ein Industrieroboter, der darauf programmiert ist, Türen in eine Autokarosserie zu schrauben, macht das perfekt. Aber nur das, und auch nur bei einem ganz bestimmten Auto – zumindest solange seine Software nicht auf eine neue Order umgeschrieben wird.

Und auch die lernenden Roboter, die es bereits gibt, lassen sich bislang nur für eine spezielle Aufgabe trimmen, etwa indem ein menschlicher Trainer ihren Arm bei einem Handgriff zunächst führt, ganz ähnlich wie Schlaganfallpatienten am Anfang einer Reha therapiert werden. Wenn die Maschine eine Bewegung dann eigenständig nachahmt, erhält sie eine positive oder negative Rückmeldung, bis der Roboter die Aufgabe sauber erledigt. Das tut sie dann auch. Aber wehe, etwas kommt dazwischen, dann scheitern sie an den einfachsten Handgriffen, und selbst am Gehen. Denn heutige Roboter sind nicht robust, sie können also kaum Störungen abfangen. Als Störung erlebt es ein Roboter bereits, wenn er gelernt hat, einen Hammer am Stiel zu greifen, ihm das Werkzeug aber auf einmal mit dem Kopf voran gereicht wird.

Ein Zyklus aus Wahrnehmen, Handeln und Lernen

„Wir möchten die Robustheit erreichen, indem wir in der Robotik auf vielfältige Weise maschinelles Lernen einsetzen“, sagt Stefan Schaal, Direktor des Tübinger Instituts. In seiner Gruppe dreht sich alles um den Zyklus aus Wahrnehmen, Handeln und Lernen . Wenn eine Maschine, das heißt ein Computer, der auch das Hirn jedes Roboters bildet, lernt, wird eine Software anhand großer Datenmengen auf eine Aufgabe trainiert. Bilderkennungsprogramme etwa lassen sich mit vielfältigen Fotos von Personen aus verschiedenen Blickwinkeln und in diversen Situationen dazu bringen, zuverlässig Gesichter auszumachen. Auch wenn diese teilweise verdeckt oder im Halbprofil zu sehen sind.

Nach diesem Prinzip gehen die Tübinger Forscher in der Schule für Roboter vor, die sie seit gut drei Jahren betreiben und in die auch Apollo geht. Dabei handelt es sich jedoch gewissermaßen um eine experimentelle Lehranstalt. Denn anders als Lehrer bringen die Tübinger Wissenschaftler ihren Schülern kein vorhandenes Wissen bei, sondern erarbeiten zunächst, was und wie Roboter am besten lernen.

Eine der maschinellen Bildungsforscher ist Jeannette Bohg. Sie will die visuelle Wahrnehmung der Maschinen so trainieren, dass ihnen ihr Sehsinn die nötigen Erkenntnisse liefert, um Handlungen sinnvoll planen zu können. Mit einer dieser Rechenvorschriften sollen die Roboter lernen, in einer fremden Szenerie schnell und zuverlässig Objekte zu finden, die sie für eine Aufgabe brauchen.

Auf der Suche etwa nach einem Laptop suchen Software-Programme in einem bottom-up-Ansatz bislang nach Pixel-Ansammlungen die aus dem Bild herausstechen, oder sie analysieren alle Gegenstände in einer Szene. Das braucht aber so viel Rechenzeit, dass ein Roboter eine Aufgabe kaum in akzeptabler Zeit erledigen kann.

Jeannette Bohg nimmt sich daher die top-down-Suchstrategie von Menschen zum Vorbild: „Wir wissen genau, wo wir nach einem Gegenstand gucken müssen und wo nicht, weil wir über Hintergrundinformationen zu ihm verfügen “, erklärt die Forscherin. „Einen Laptop zum Beispiel erwarten wir auf einem Tisch und nicht an der Wand.“ Dort aber können wir eine Uhr finden, die eine Person jedoch auch am Handgelenk tragen kann. In einer Szene zunächst die Orte zu identifizieren, wo sich die Suche lohnt, ist für einen Roboter nicht zuletzt hilfreich, weil er dann näher an die Stellen herantreten kann, um sie genauer zu untersuchen – so wie wir Menschen es auch oft tun.

Um die menschlichen Suchtechniken auch ihren Maschinen-Schülern nahezubringen, erforscht Jeannette Bohg, wie sich die menschliche Suchstrategie am besten mit einer Software nachahmen lässt. Diese trainiert sie dann mit den Augenbewegungen, mit denen 15 Probanden 400 Bilder etwa nach einer Uhr oder einem Laptop abtasteten. Anhand dieser Daten sammelt ein Roboter die Erfahrung, die Menschen lehrt, wo ein bestimmter Gegenstand auftreten kann.

„Uhren und Laptops lokalisiert unser Such-Algorithmus nach dem Training schon sehr gut“, sagt Jeannette Bohg. Allerdings findet die Technik einzelne Objekte nicht ganz so zuverlässig wie die Methoden der Bilderkennung, die das gesamte Bild analysieren. „Mit 400 Bildern ist der Datensatz für das Training allerdings auch noch ziemlich begrenzt“, so Bohg.

Immense Datenmengen für ein Elektronikhirn

Ausreichend Daten anzuhäufen und aus diesen die richtigen Schlüsse zu ziehen, um für alle Eventualitäten des autonomen Daseins gewappnet zu sein, ist für die Maschinen ein generelles Problem: Einen brauchbaren Erfahrungsschatz aufzubauen, der sie unabhängig von Vorgaben oder Interventionen machen könnte, würde locker ihr ganzes Roboterleben füllen, das genauso endlich ist wie das Dasein eines Computers, eines Autos oder das des Menschen. Die immensen Datenmengen könnte ein einzelnes Elektronikhirn zudem kaum handhaben. Lösen ließe sich dieses Problem möglicherweise mit Cloud-Robotik: Ähnlich wie heute schon unzählige Computer vernetzt werden, um große diverse Aufgaben zu lösen, könnten sich Roboter der ganzen Welt vereinigen, um ihr Wissen selbstlos zu teilen – vorausgesetzt ihre Programme sind miteinander kompatibel.

Einstweilen müht sich jeder Roboter noch alleine mit all dem Wissen, das für ein halbwegs selbstständiges Agieren nötig ist. Zum Beispiel auch damit, den richtigen Griff zu planen, wenn er einen Gegenstand sieht – ein weiteres Forschungsthema von Jeannette Bohg.

In der Vergangenheit ließen Robotik-Forscher einen Roboter zunächst berechnen, an welchen Punkten seine Finger einen Gegenstand berühren müssen, um ihn sicher zu greifen. „Man ging davon aus, dass der Roboter von dem Objekt und von sich selbst ein detailliertes geometrisches Modell kennt, um die Ansatzpunkte für den Griff zu berechnen, und dass er diese Punkte auch präzise erreicht“, erklärt Jeannette Bohg. Anhand der Modelle plante der Roboter dann, wie er einen Gegenstand greifen muss, damit dieser nicht runterfällt.

„Es hat sich aber gezeigt, dass diese Annahmen nicht realistisch sind“, so Jeannette Bohg. Nicht nur, dass ein Roboter nicht von jedem Ding, nach dem er langen könnte, ein Modell abgespeichert hat. Seine Steuerung arbeitet auch nicht präzise genug, um einmal berechnete Ansatzpunkte für einen Griff genau zu erreichen, zumal die Daten seiner Sensoren, anhand derer er seine Bewegungen kontrolliert, oft unvollständig und verrauscht sind. So fingerte die Maschine bis dato oft unbeholfen und vergeblich nach einem Gegenstand. Jeannette Bohg will das ändern und orientiert sich dabei wieder an den Menschen, die selbst Gegenstände, die sie noch nie gesehen haben, zuverlässig fassen können.

Die Informatikerin hat zu diesem eine Datenbank aufgebaut, die sie mit Modellen von mehr als 700 Gegenständen gefüttert hat – vom Hammer bis zur Spielzeug-Puppe. Damit der Roboter lernt, wie er erfolgreich nach diesen Objekten greift, simuliert sie unzählige mögliche Griffe am Rechner. Dabei berücksichtigt die Forscherin auch, dass ein Gegenstand seine Position verändert, wenn der Roboter ihn zuerst nicht mit seiner Handfläche, sondern mit den Kuppen seiner Finger berührt, die das Objekt beim Zugreifen verschieben. Das Ding rutscht ihm dabei möglicherweise gerade noch in die Hand oder eben nicht.

Anhand der Erfahrung, die die Software in den Simulationen aufbaut, soll ein Roboter später nicht nur die Dinge aus dem gelernten Fundus zu fassen bekommen, sondern auch unbekannte Objekte. Und das sogar, wenn seine Sensoren ihm nur unvollständige und verrauschte Informationen liefern.

Feinfühlige Maschinen

Robotern zu einer zupackenden Art zu verhelfen, ist auch ein Ziel von Ludovic Righetti, der am Tübinger Max-Planck-Institut eine Forschungsgruppe leitet. Doch während es Jeannette Bohg darum geht, dass ein Roboter anhand visueller Informationen einen zuverlässigen Griff nach einem unbekannten Gegenstand plant, setzen Ludovic Righetti und seine Mitarbeiter an anderer Stelle dieser Handlung an: Sie bringen Schülern wie Apollo unter anderem bei, gefühlvoller zuzupacken. Auf diese Weise soll die Roboterhand einen Gegenstand auch dann erwischen, wenn sie auf ihn nicht genau an der geplanten Stelle trifft.

Solche Aktionen sind ein Fall für die Regelungstechnik: das Computerprogramm, das Informationen von den Sensoren mit der Arbeit der Motoren rückkoppelt. Die Gefühle ‚Ich hab’s‘ und‚Ich hab’s noch nicht‘ kleiden sich bei Apollo in Daten, die Kraftsensoren in seiner Hand messen. Die Kontrolleinheit in seinem Hirn erzeugt aus den Daten einen Befehl für die Motoren der Finger. Die Sensoren melden dann zurück, ob die Finger tatsächlich dort landen, wo sie hinsollten. Tun sie das nicht korrigiert die Software. Eine solche Regelung basiert stets auf einem Modell, das die Konstruktion eines Roboters sowie das Zusammenspiel zwischen dessen Steuerung und Motoren in mathematische Formel fasst.

Tatsächlich ist das korrekte Modell von Blechmann oder -frau eine knifflige Angelegenheit: „Die Physik eines Roboters ist hochgradig nichtlinear“, sagt Stefan Schaal. Das heißt kleine Abweichungen von den Annahmen des Modells etwa in der Empfindlichkeit von Sensoren oder der Kraft eines Motors können gravierende Auswirkungen haben. Der Roboter spielt dann möglicherweise komplett verrückt, jedenfalls tut er nicht mehr, was von ihm erwartet wird. Das liegt vor allem daran, dass ein Roboter mit komplettem Körper insgesamt rund 40 Freiheitsgrade hat: Er kann seine diversen Gliedmaßen mithilfe von 40 voneinander unabhängiger Gelenke bewegen.

Doch im physikalischen Modell, auf dem die Steuerung des Roboters beruht, liegt nicht einmal das eigentliche Problem, das lässt sich trotz aller Widrigkeiten in den Griff bekommen. „Ich kann ein gutes Modell von meinem Roboter hinbekommen, aber nicht von einer unbekannten Umgebung“, so Schaal.

Daher bringt ein Teil von Righettis Team Robotern mithilfe des maschinellen Lernens bei, ein flexibleres Modell für eine bestimmte Aufgabe zu entwickeln – zum Beispiel den Griff nach einer Tasse. „Der Roboter lernt dabei, wie sich eine Aktion zu jedem Zeitpunkt anfühlen sollte, was also die Kraftsensoren in seinen Handgelenken, die haptischen Sensoren an den Fingern und die Kameraaugen registrieren sollten“, sagt Righetti. „Das ist eine relativ einfache Form des Lernens.“ Sitzt der Griff nicht, können Apollo und seine Mitschüler ihn mit ihrer anpassungsfähigen Steuerung korrigieren. „Letztlich wollen wir zu allgemeineren Modellen kommen, die sich auf viele verschiedene Aufgaben anwenden lassen.“

Righettis Team setzt dabei auf Modelle, die wissen oder zumindest wissen sollten, welche Kräfte der Motoren zu welcher Bewegung führen – die Forscher regeln dann die Kräfte und damit die Aktion der Maschine. Die meisten Robotik-Wissenschaftler verwenden heute dagegen noch Regelungen, deren Befehle für die Hand oder den Fuß eines Roboters explizit eine Position vorgeben, die erreicht werden soll.

Das klingt nach einem technischen Detail, hat aber ganz praktische Konsequenzen: Wenn Regelungen ihren Erfolg daran messen, ob etwa eine Hand die Zielposition erreicht, will sie sich davon nicht abbringen lassen – auch von einem Menschen nicht, der ihr gerade in die Quere kommt. Im Zweifelsfall wendet der Roboter mehr Kraft auf, um sich durchzusetzen. So kann es etwa zu schlimmen Unfällen mit den besonders hart durchgreifenden Industrierobotern kommen.

Wird dagegen direkt die Kraft reguliert, kann die Maschine auf mehr Feinfühligkeit programmiert werden – eine unabdingbare Voraussetzung im Umgang mit Menschen. „Unsere kraftkontrollierten Roboter können viel nachgiebiger und trotzdem präzise agieren, weil wir weniger fehleranfällige Modelle verwenden“, sagt Righetti. „Dieser Ansatz eröffnet viele Möglichkeiten und wird sich in Zukunft sicher verbreiten.“

Unterrichtsmaterial für Roboter

Auch Sebastian Trimpe arbeitet daran, wie sich die Regelung eines Roboters durch maschinelles Lernen verbessern lässt. Er entwickelt gewissermaßen das Unterrichtsmaterial, damit Roboter unter anderem lernen, einen Stab zu balancieren, ganz ähnlich wie Kinder einen Stock auf einem Finger im Gleichgewicht halten. „Das ist eine relativ einfache Aufgabe“, sagt Sebastian Trimpe. „Aber wenn wir verstehen, wie ein Roboter sich diese am besten aneignet, können wir ihm vielleicht beibringen, wie er auch anspruchsvolle Aufgaben erlernt.“ Etwa auf unbekanntem und unebenem Grund zu stehen und zu gehen.

Um einstweilen einen Stab in der Balance zu halten, arbeitet in Apollo ein Regleralgorithmus, der Sensorinformation über die aktuelle Lage und Bewegung des Stabs analysiert und in Steuerungssignale für die Elektromotoren umwandelt. Wenn der Stab etwa droht, nach rechts zu kippen, greift der Regler ein und korrigiert Apollos Bewegung, um das Kippen zu verhindern.

Sein Lehrer macht es ihm dabei nicht einmal besonders einfach, denn er lässt ihn zunächst einen kurzen Stab in der Schwebe halten. Das ist schwieriger, als einen langen Stab zu balancieren, weil der kurze Stab aufgrund seiner geringeren Trägheit schneller kippt und daher eine raschere Reaktion erfordert. Apollo jedoch hält den kurzen Stab mühelos aufrecht, scheitert aber erst einmal kläglich, als er das Gleiche mit einem längeren Stab versucht.

Für Sebastian Trimpe ist es kein Wunder, dass der Versuch schief gegangen ist: Wieviel Ausgleichsbewegung nötig ist, hängt von der Länge des Stabes ab, die der Regleralgorithmus berücksichtigt. Den Algorithmus haben die Forscher aber nicht angepasst, als sie Apollo den langen Stab in die Hand drückten. Die Regelung, die für den kurzen Stab prima funktioniert, versagt also beim langen Stab, weil Apollo mit ihren Vorgaben im Kopf viel zu schnell mit seinem Arm fuchtelt.

„Anstatt für jeden neuen Stab eine neue Regelung zu programmieren, haben wir die Regelungssoftware so angepasst, dass sie selbstständig lernt“, sagt Sebastian Trimpe. Mithilfe des maschinellen Lernens kann sich der Roboter also autonom auf neue Situationen einstellen, ohne dass diese vorher genau einprogrammiert wurden. In der Regelungstechnik, einer Domäne der klassischen Ingenieurwissenschaften verfolgt er so einen neuen Ansatz.

Obendrein haben die Forscher Apollo eine Anleitung in sein Kontrollzentrum geschrieben, nach der er sich den besten Regler möglichst effizient, das heißt mit möglichst wenigen Versuchen, aneignet. „Der Algorithmus schlägt automatisch denjenigen Regler vor, bei dem der Lerneffekt am größten ist“, so Trimpe. Gerade zu Beginn des Lernprozesses können das auch Regler sein, bei denen die Unterschiede zum ursprünglichen Regler ziemlich groß sind. So wirken der zweite und dritte Balanceversuch Apollos noch unbeholfener als der erste, was der Roboter völlig ungerührt hinnimmt. Danach aber geht es mit einer durchaus steilen Lernkurve aufwärts.

„Anders als bei typischen Anwendungen des maschinellen Lernens etwa in der Bilderkennung handelt es sich beim Lernen in der Robotik um ein dynamisches Problem“, sagt Sebastian Trimpe. Der Datensatz, mit dem eine Software lernt, Gesichter zu erkennen, verändert sich nicht. Ein Roboter sammelt dagegen ständig neue Erfahrungen, während er sich durch die Welt bewegt und in ihr handelt. Er sollte daher lebenslang lernen. Dabei gerät er immer wieder in ein Dilemma.

„Um Neues zu lernen oder besser zu werden, muss der Roboter neues Verhalten ausprobieren“, so Trimpe. Das könne zur Folge haben, dass er zeitweilig auch schlechter werde. Damit er dann keinen Unsinn macht oder gar Schaden nimmt, etwa wenn er stürzt, müssen die Forscher in den Lernalgorithmus Garantien einbauen. Mithilfe mathematischer Beweistechniken setzen sie der Neugier des Roboters Leitplanken, sodass er nicht nur flexibles, sondern auch sinnvolles und robustes Verhalten lernt.

Wenn es darum geht, die Regelung eines Roboters robuster, also weniger störanfällig zu machen, verlässt sich Ludovic Righetti nicht alleine auf die Lernfähigkeit der Maschinen. Seine Arbeit steht mustergültig dafür, dass die Robotik nicht nur einer einzigen Route folgen kann, um autonome Hilfsmaschinen für den Haushalt oder gar den Katastrophenschutz zu entwickeln.

Ein ständiger Balanceakt

„Wir möchten den Ansatz, in dem ein Roboter Modelle durch Erfahrung entwickelt, mit einer anderen Herangehensweise in der Regelungstechnik kombinieren“, sagt Righetti. Er und seine Mitarbeiter schreiben die Flexibilität, die für spontane Korrekturen einer Bewegung nötig ist, auch schon in die Algorithmen der Steuerung, die Sensordaten mit Befehlen für die Roboter-Motoren rückkoppeln. Ob dabei eine sinnvolle Handlung wie etwa der Griff nach einer Tasse oder ein Balanceakt auf wackligem Untergrund herauskommt, kann aus Sicht der Regelungstechnik als mathematisches Optimierungsproblem formuliert werden, dessen Lösung den besten Regler für die jeweilige Aufgabe liefert.

Oft lässt sich ein Regler vor dem Betrieb optimieren. Geht das nicht, weil etwas Unvorhergesehenes passieren kann – etwa dass der Roboter stolpert oder geschubst wird – muss er mitten in der Aktion, zum Beispiel beim Gehen, verbessert werden. „Dafür haben wir starke Algorithmen entwickelt“, sagt Ludovic Righetti.

Die Methoden berechnen nicht nur sehr zuverlässig, wie der Regler auf unerwartete Ereignisse angepasst werden muss. Die Software von Righettis Team arbeitet auch sehr schnell. Das darf gar nicht anders sein. Vor allem wenn ein Roboter auf unebenem Grund gehen soll. „Der Roboter hat dann nur wenige Millisekunden, um seine Haltung zu korrigieren, sobald er aus der Balance gerät“, sagt Ludovic Righetti. Schafft er das nicht, fällt er.

Wie gut eine Maschine mit ihrer Regelung die Balance hält, hat Righettis Team an Hermes bewiesen. Hermes ist gewissermaßen das Gegenstück zu Apollo, er besteht nämlich nur aus Unterleib und zwei Beinen. Dass es nur zwei sind hat einen guten Grund: Vier und mehr Beine oder gar Räder geben einem Roboter zwar mehr Standfestigkeit, aber viele Hindernisse kann ein Roboter nur überwinden, wenn er mit zwei Beinen und zwei Armen über sie drüber klettert.

Mit dem zweibeinigen Hermes experimentierten Stefan Schaal und Ludovic Righetti an der University of Southern California, wo sie bereits forschten, ehe sie an das Tübinger Max-Planck-Institut kamen. Bringen die Forscher Hermes etwa mit einem Stoß aus dem Gleichgewicht, korrigiert er seine Haltung mit geradezu menschlich anmutenden Ausgleichsbewegungen.

Die neue Steuerung macht Schule: „Inzwischen wird sie in vielen Robotern eingesetzt“, sagt Righetti. Auch dem jüngsten Zugang im Olymp des Tübinger Instituts wird die Regelung beim Balancieren helfen: Athena, die als erster Roboter auf einem Sitzplatz aus den USA nach Deutschland geflogen ist. Sie erfüllt ebenfalls nicht ganz die Erwartungen, die sich mit dem Namen der Göttin verbinden. Ein mächtiger Oberkörper, kräftige Arme, Hydraulikschläuche und ihr Maschinenkopf, den sie nicht einmal immer trägt, verleihen ihr die Anmut eines Transformers. Immerhin besitzt sie beides, Arme und Beine.

Wie Athena alle ihre Gliedmaßen am besten koordiniert, wenn sie mehrere Aufgaben gleichzeitig lösen soll, darum wird es in der Forschung von Ludovic Righetti und seinen Mitarbeitern künftig gehen. Auch um die Frage, wie sie die richtigen Prioritäten setzt, wenn sie auf unebenem Grund gehend oder stehend nach einem Gegenstand greifen soll. Denn die Maschine weiß erst einmal nicht, dass es wichtiger ist die Haltung zu bewahren statt unbedingt das Ding in die Hand zu bekommen. Ein brauchbarer Helfer im Alltag muss da sinnvolle Entscheidungen treffen.

Bis Roboter selbstständig genug werden, um etwa hilfsbedürftige Menschen zu unterstützen, wird es noch eine Weile dauern. Denn an zu vielen Punkten im Zyklus aus Wahrnehmung, Lernen und Handeln muss die Robotik noch kräftig nachjustieren. So geht Stefan Schaal auch nicht davon aus, dass uns in 30 Jahren Wesen aus Blech, Plastik und Elektronik pflegen werden, und zwar schon aus rein technischen Gründen, von der gesellschaftlichen Akzeptanz ganz zu schweigen. „Aber ich werde hoffentlich noch erleben, dass uns Roboter im Haushalt helfen, und sei es nur, dass sie auf Zuruf etwa ein Buch aufheben, wenn wir uns nicht mehr bücken können“, sagt der Wissenschaftler.

Auf den Punkt gebracht

Roboter können sich heute noch nicht flexibel auf neue Aufgaben und unerwartete Situationen einstellen. Zudem sind sie störanfällig.

Unter anderem mithilfe des maschinellen Lernens wollen Tübinger Max-Planck-Forscher ihnen etwa beibringen, schnell und zuverlässig Gegenstände in einer unbekannten Umgebung zu finden, Objekte, die sie nicht kennen, sicher zu greifen und selbstständig die geeignete Regelung für neue Aufgaben zu erlernen.

Um Robotern zu mehr Standfestigkeit und einem sichereren Gang zu verhelfen, programmieren sie die Regelung zudem so, dass Maschinen ihre Aktionen immer wieder neu optimieren und so etwa auf Störungen reagieren.